实战-kubeadm方式搭建k8s集群-v1-20-0-20210530-测试成功-良哥-荐(CRI-Docker)

实战:kubeadm方式搭建k8s集群(k8s-v1.20.0,docker-20.10.7-ce)-2021.5.30(部署成功-良哥)【荐】

目录

[toc]

实验环境

1、硬件环境

3台虚机 2c2g,20g。(nat模式,可访问外网)

| 角色 | 主机名 | ip | 显示名称 |

|---|---|---|---|

| master节点 | k8s-master | 172.29.9.31 | k8s-master-172.29.9.31 |

| node节点 | k8s-node1 | 172.29.9.32 | k8s-node1-172.29.9.32 |

| node节点 | k8s-node2 | 172.29.9.33 | k8s-node2-172.29.9.33 |

2、软件环境

| 软件 | 版本 |

|---|---|

| 操作系统 | centos7.7_x64 1908 mini(其他centos7.x版本也行) |

| docker | 20.10.7-ce |

| kubernetes | v1.20.0 |

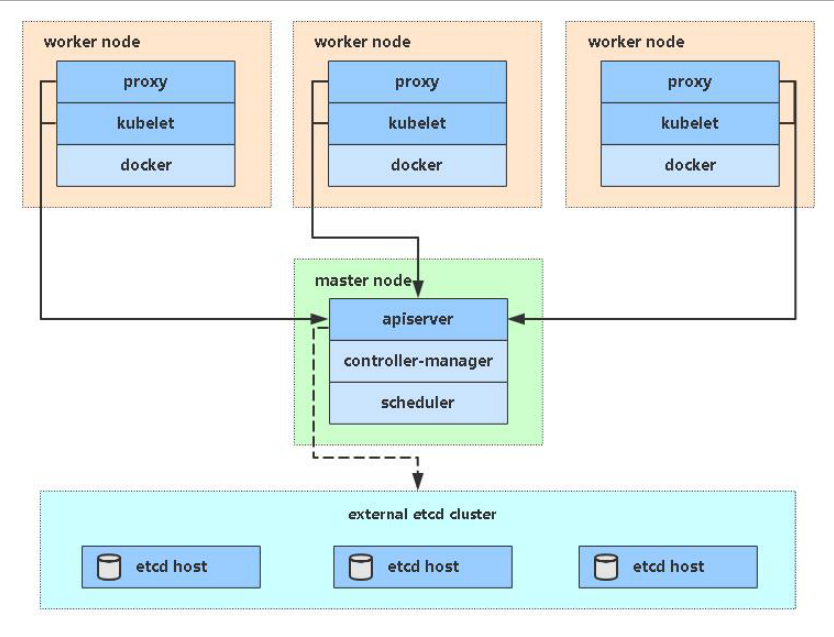

3、架构图

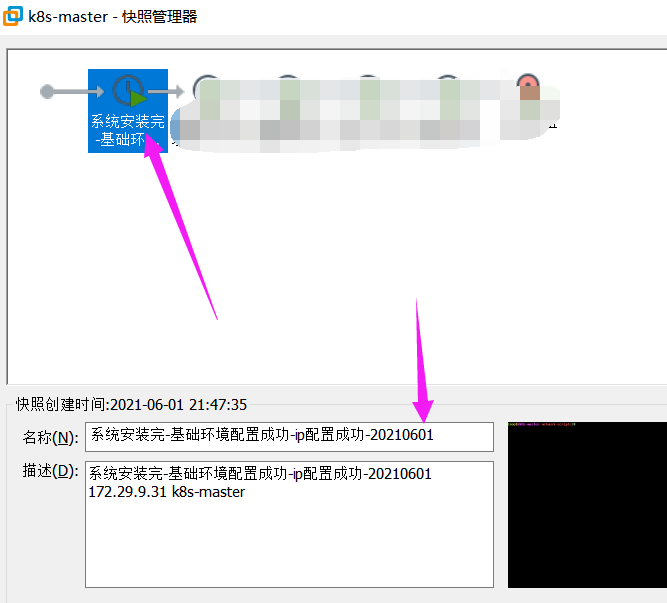

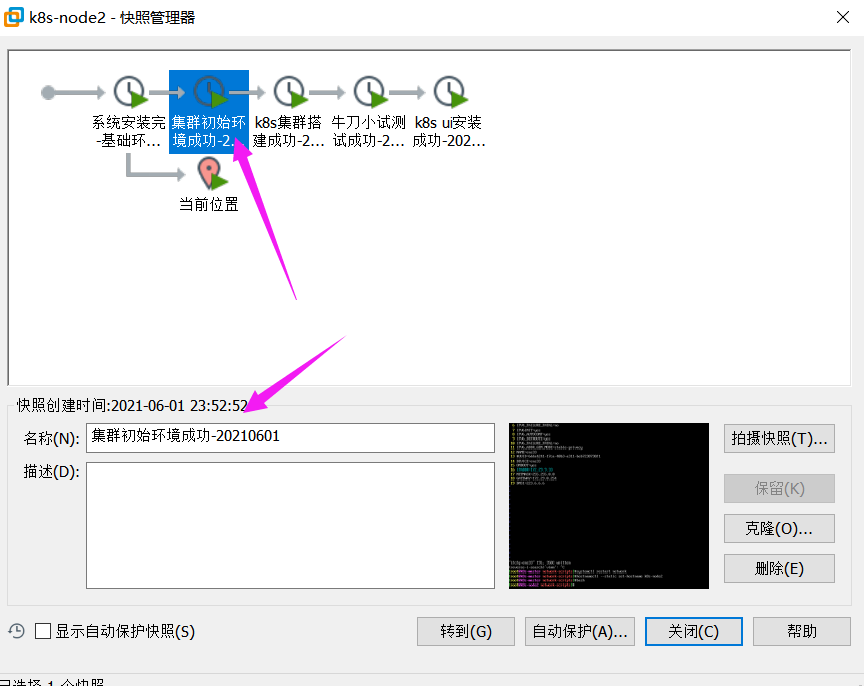

- 注意:在将要做实验之前,请准备好如上3台虚机,并做好基础网络配置。然后做一个快照,方便后期回滚。

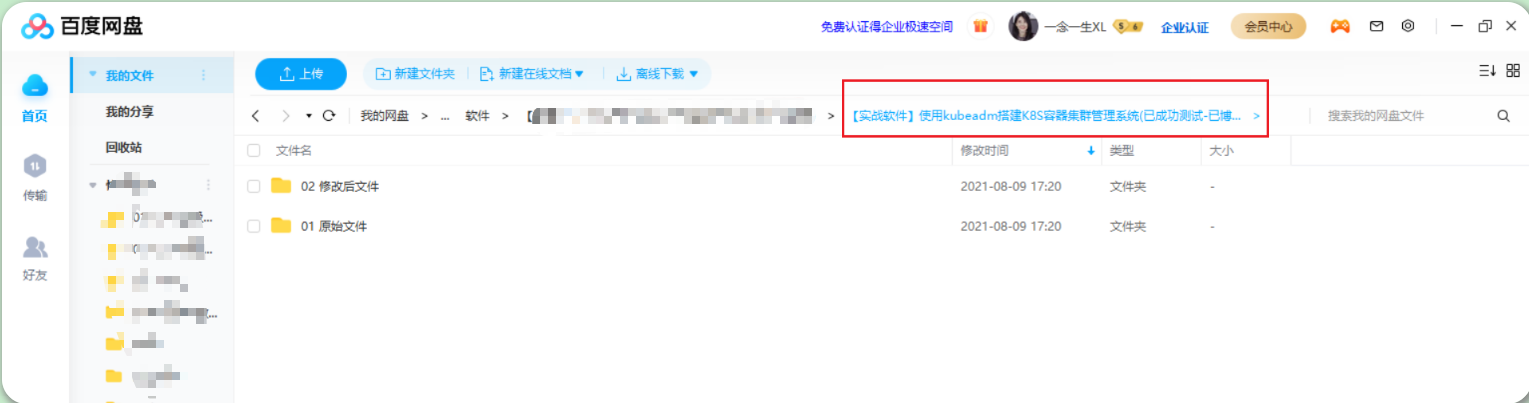

实验软件

链接:https://pan.baidu.com/s/1bJwyaQlXX5ZL8Bq_9tNZBQ 提取码:iokw

百度云盘位置:

0.集群环境配置

👉 (all节点均要配置)

(1)Linux基础环境配置

关闭且禁用如下服务:firewalld、NetworkManager、selinux

systemctl stop firewalld && systemctl disable firewalld

systemctl stop NetworkManager && systemctl disable NetworkManager

setenforce 0

sed -i s/SELINUX=enforcing/SELINUX=disabled/ /etc/selinux/config(2)关闭swap分区

说明:以下提供了2种关闭swap分区的方法,这里2条命令都刷一下!

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab #呃呃呃,这个要重启机器才会生效的!!!(3)设置主机名

hostnamectl --static set-hostname k8s-master1

bash

hostnamectl --static set-hostname k8s-node1

bash

hostnamectl --static set-hostname k8s-node2

bash(4)添加hosts

cat >> /etc/hosts << EOF

172.29.9.31 k8s-master1

172.29.9.32 k8s-node1

172.29.9.33 k8s-node2

EOF#注意:

本次实验,这个只需要在master节点执行就好了;

因为我们后面在用kubectl去连接容器时,会用到这个主机名与它的对应关系;因为k8s使用这个主机名去注册到k8s集群,用主机名去连接kubelet。

而有的文档这里都对所有节点添加了此项内容;

#个人建议对all节点均配置这个hosts文件内容;(5)将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system说明:这个是一定要配置的;不配置的话,在安装过程中会有warning的;

(6)时间同步

yum install ntpdate -y

ntpdate time.windows.com说明: 因为里面涉及到证书,而证书对时间是很敏感的,里面的校验都是需要用到时间的,因此这3台机器必须保持时间同步;

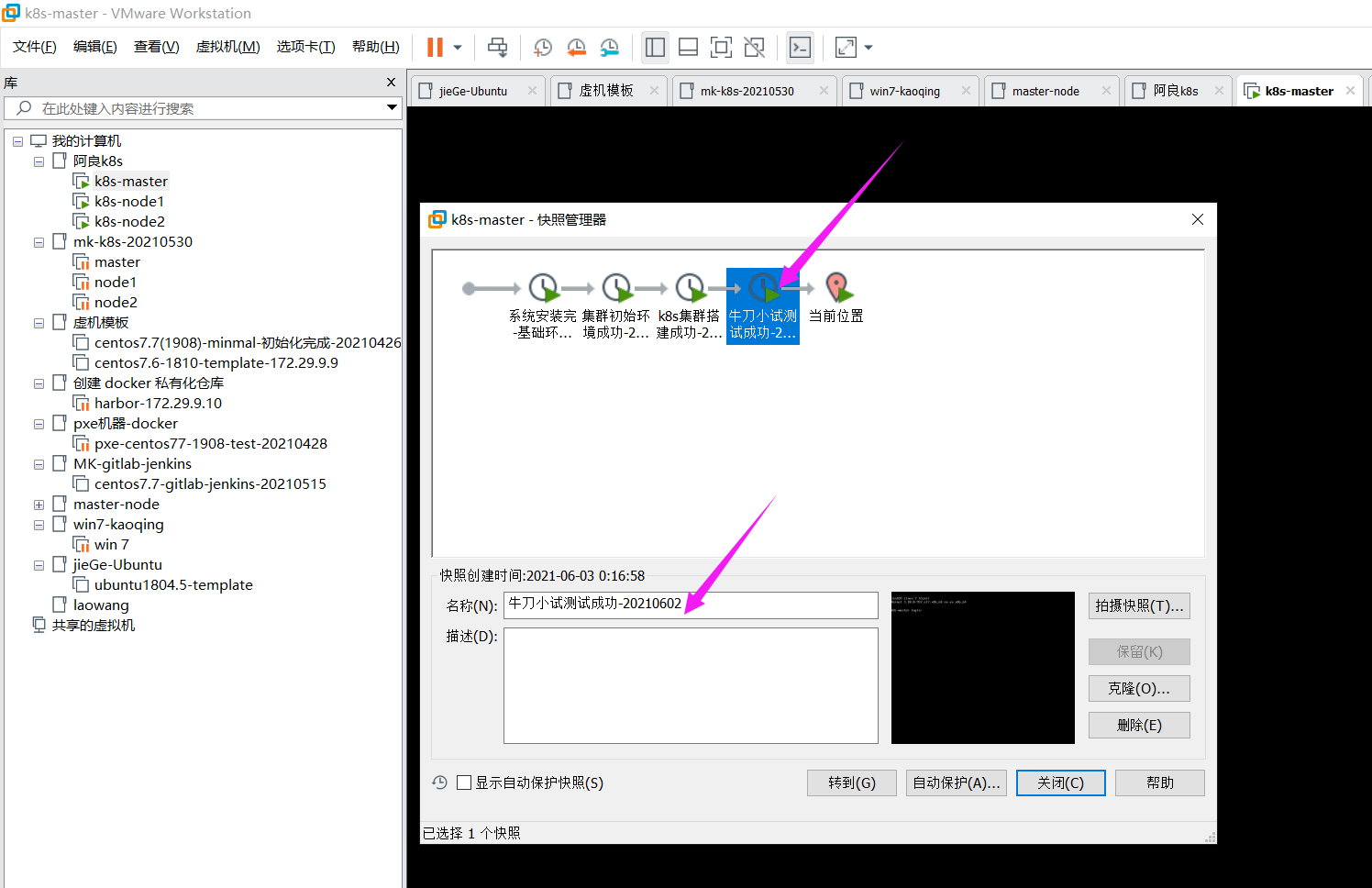

- 到此,集群初始化工作已经完成了,此时对3台机器做一个快照。

接下来,将在all节点安装Docker/kubeadm/kubelet。

1.安装Docker/kubeadm/kubelet(所有节点均要配置)

(1)安装Docker

- 执行如下代码

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#yum install docker-ce -y

#本次安装docker指定版本

yum install -y yum install docker-ce-20.10.7 docker-ce-cli-20.10.7 containerd.io

systemctl start docker && systemctl enable docker

mkdir -p /etc/docker

tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors":["https://dockerhub.azk8s.cn","http://hub-mirror.c.163.com","http://qtid6917.mirror.aliyuncs.com"]

}

EOF

echo "net.ipv4.ip_forward = 1" >> /etc/sysctl.conf

sysctl -p

systemctl daemon-reload

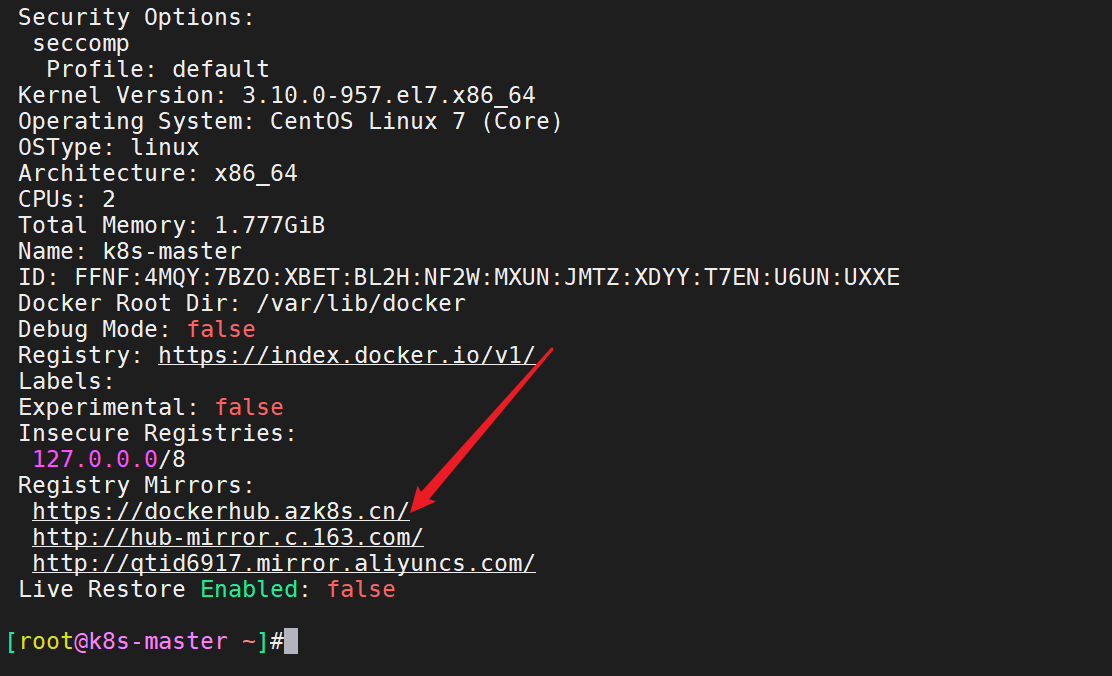

systemctl restart docker- 安装后验证

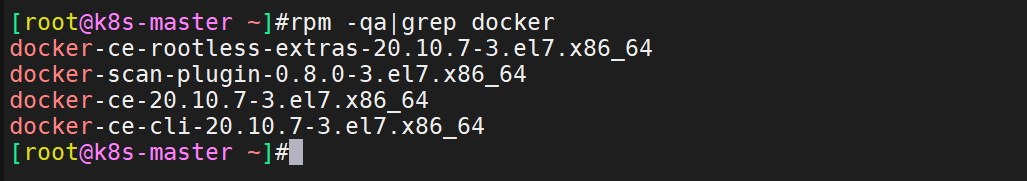

[root@k8s-master ~]#rpm -qa|grep docker

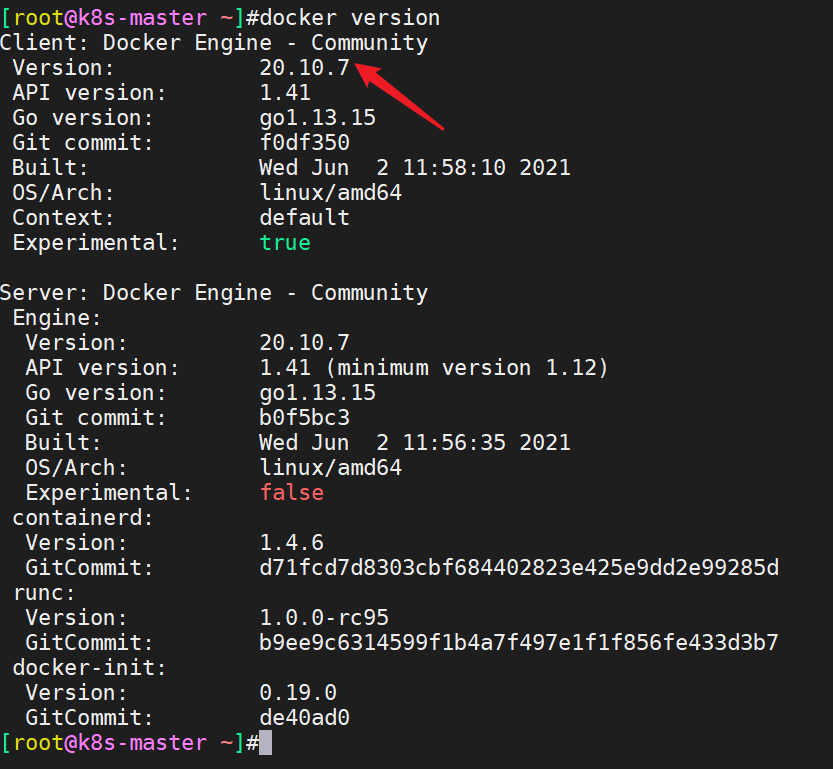

[root@k8s-master ~]#docker version

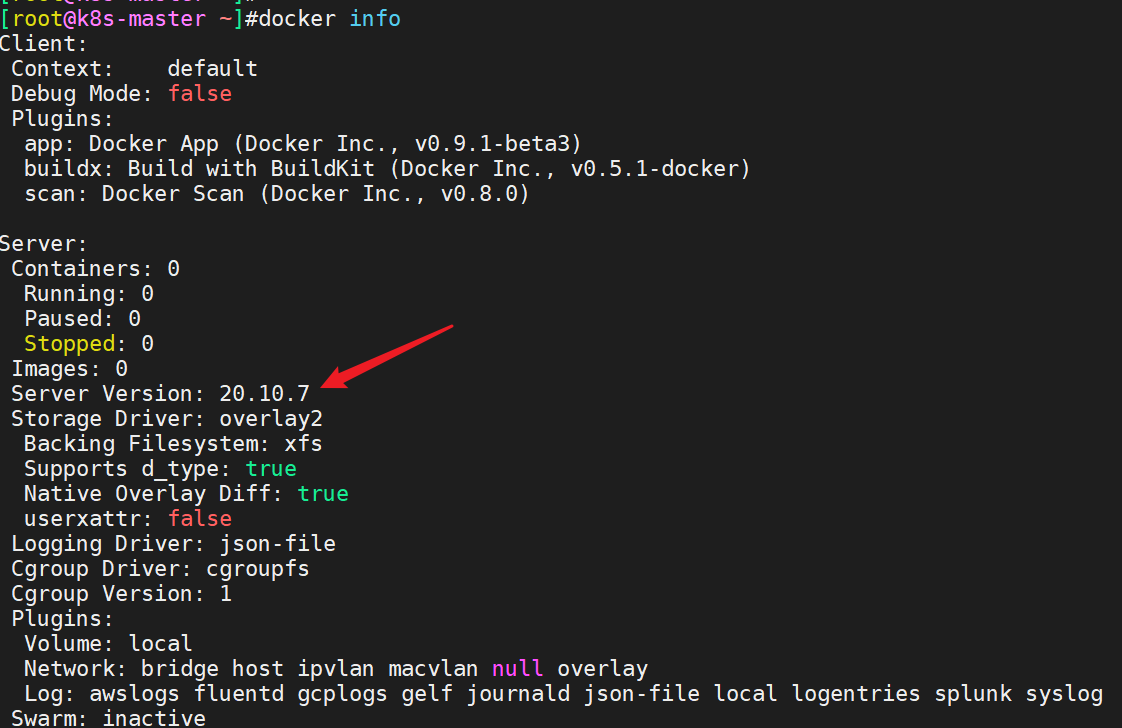

[root@k8s-master ~]#docker info

(2)添加阿里云YUM软件源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF这边注意:

(3)安装kubeadm,kubelet和kubectl

由于版本更新频繁,这里指定版本号部署:

yum makecache fast

yum install -y kubelet-1.20.0 kubeadm-1.20.0 kubectl-1.20.0 --disableexcludes=kubernetes #注意,这些好都是阿里云kubernetes.repo仓库里的包 #--disableexcludes 禁掉除了kubernetes之外的别的仓库

kubeadm version

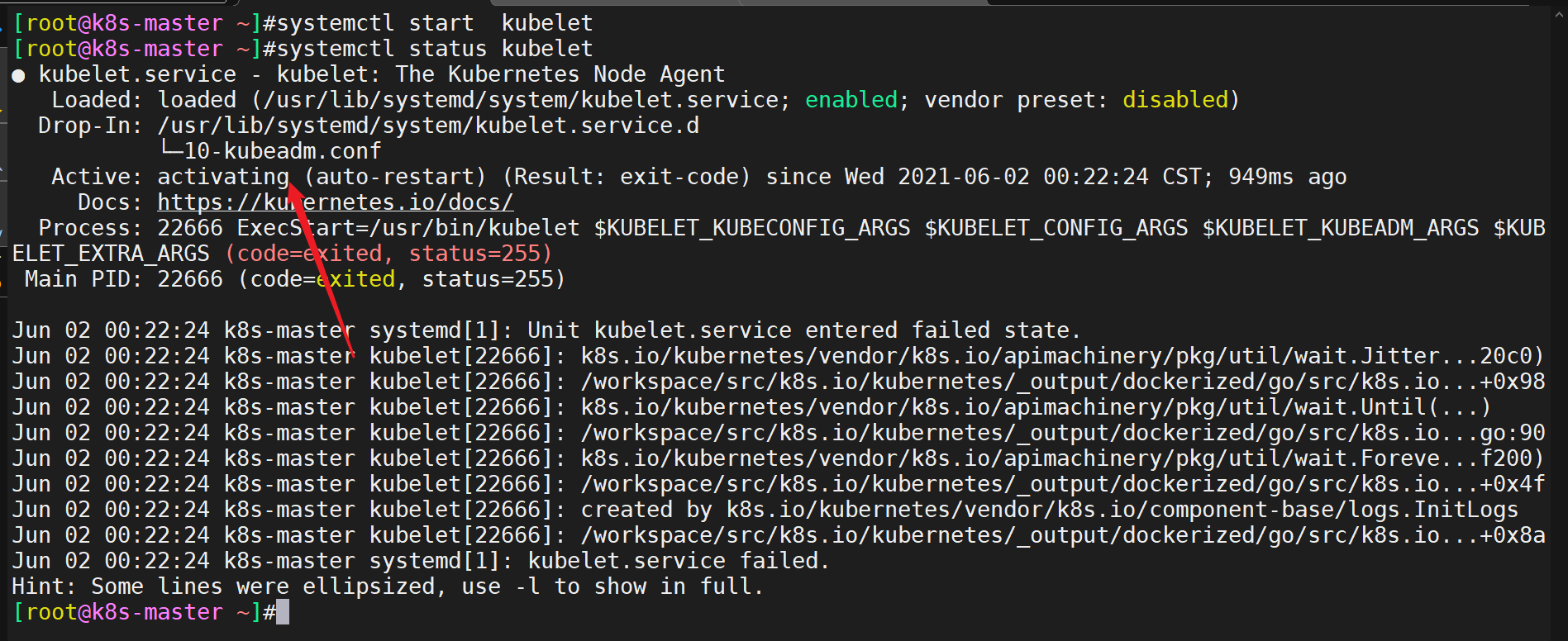

systemctl enable kubelet- 说明:这里要特别注意

我们不需要去启动kubelet服务,只要设置开机自启就好(此时,启动也启动不起来的);

因为要生成配置文件,这样才可以把kubelet拉起;

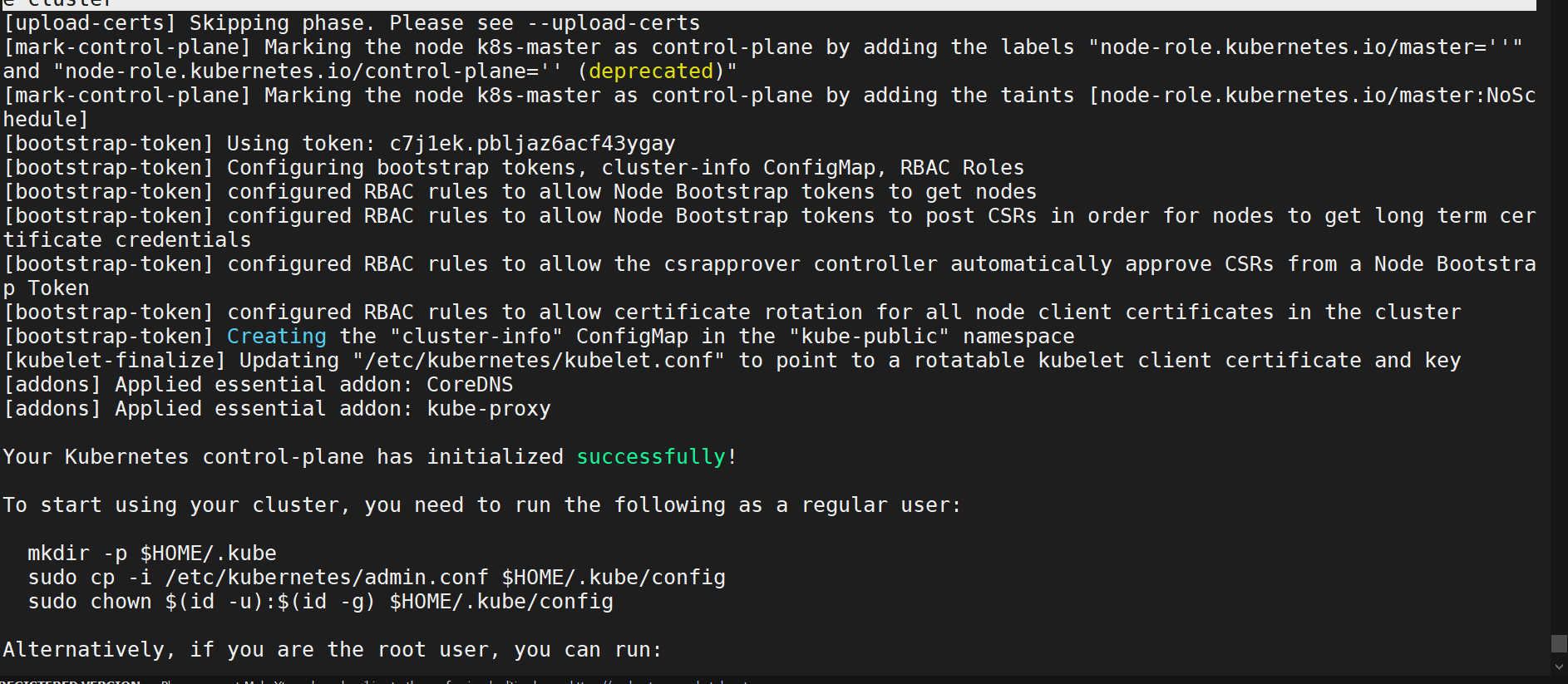

2.创建Master节点(在master节点执行)

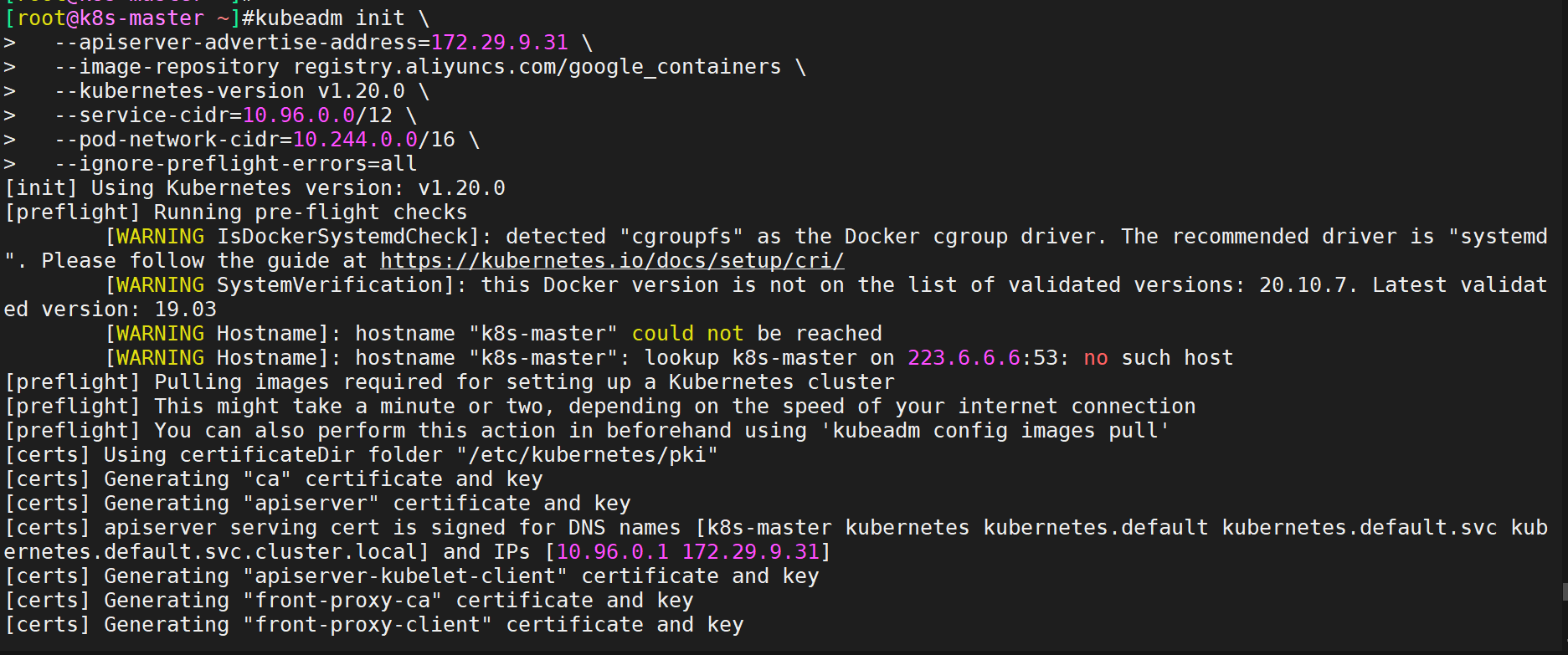

- 执行如下代码

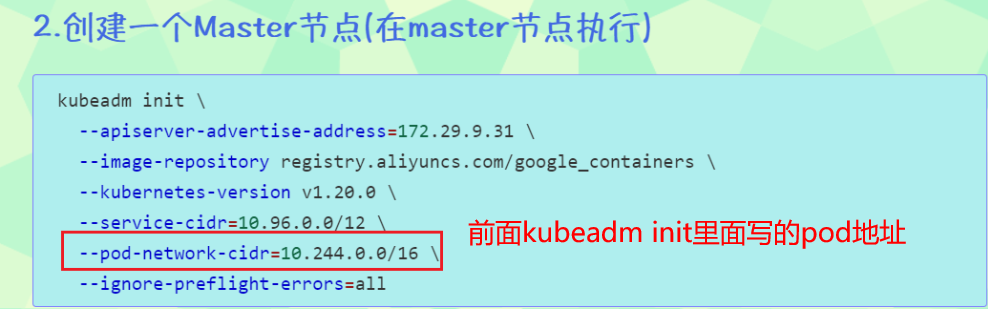

kubeadm init \

--apiserver-advertise-address=172.29.9.31 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.20.0 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16 \

--ignore-preflight-errors=all#说明:

kubeadm init \

--apiserver-advertise-address=172.29.9.31 \ #这里的ip填自己master ip就好

--image-repository registry.aliyuncs.com/google_containers \ #修改为阿里云的地址

--kubernetes-version v1.20.0 \ #指定版本

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16 \ #与下面部署的CNI网络组件yaml中保持一致

--ignore-preflight-errors=all

--apiserver-advertise-address 集群通告地址

--image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址

--kubernetes-version K8s版本,与上面安装的kubeadm/kubectl/kubelet一致

--service-cidr 集群内部虚拟网络,Pod统一访问入口

--pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

--ignore-preflight-errors=all 忽略不核心的报错;#说明

初始化的时候会拉取镜像,--kubernetes-version v1.20.0 这里指定了版本,就指明了要拉取哪个版本的镜像;

版本一定要和组件版本`yum install -y kubelet-1.20.0 kubeadm-1.20.0 kubectl-1.20.0`保持一致,否则会出现一些问题;

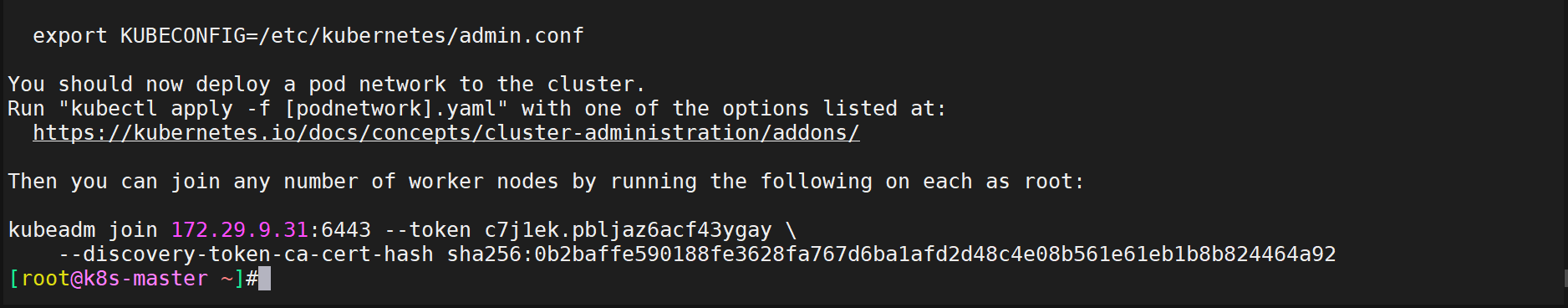

它以容器的方式启动一个组件:

[root@k8s-master ~]#docker images

REPOSITORY TAG

registry.aliyuncs.com/google_containers/kube-proxy v1.20.0

registry.aliyuncs.com/google_containers/kube-apiserver v1.20.0

registry.aliyuncs.com/google_containers/kube-controller-manager v1.20.0

registry.aliyuncs.com/google_containers/kube-scheduler v1.20.0

registry.aliyuncs.com/google_containers/etcd 3.4.13-0

registry.aliyuncs.com/google_containers/coredns 1.7.0

registry.aliyuncs.com/google_containers/pause 3.2

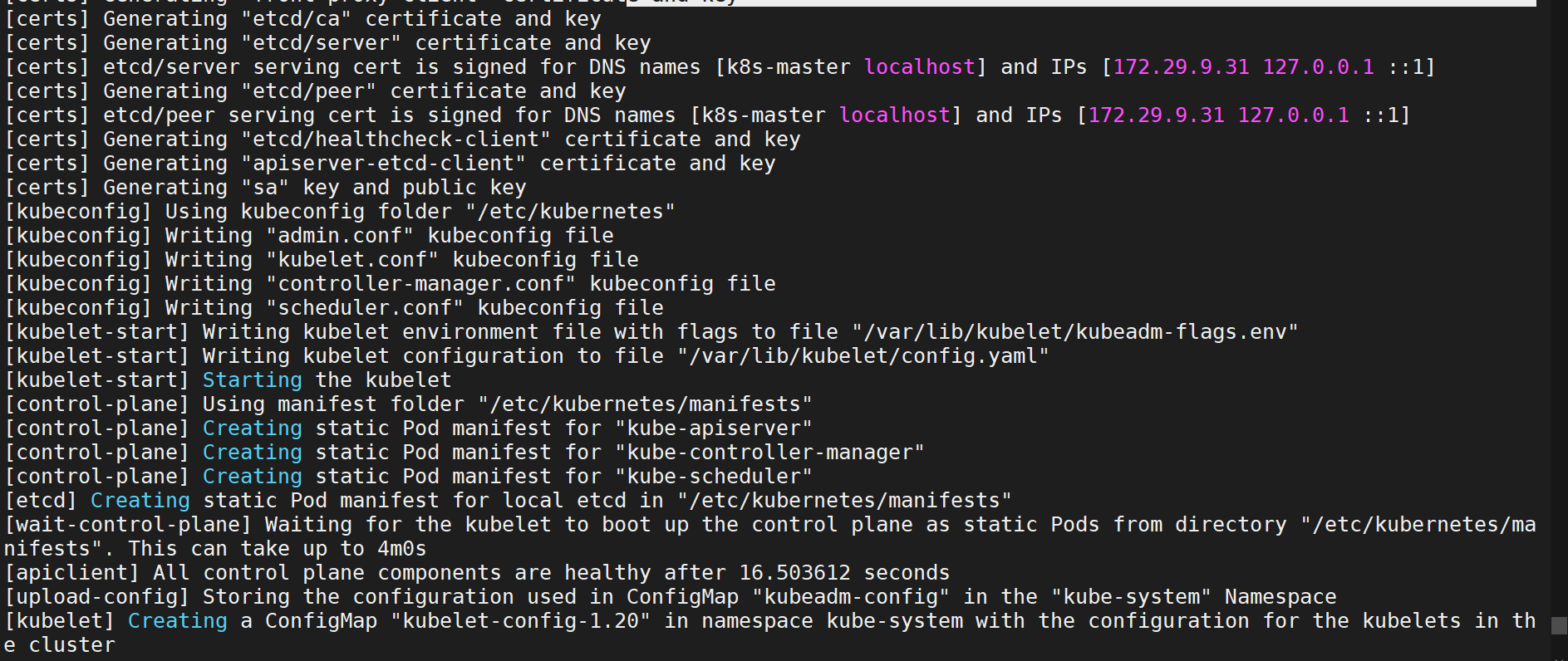

[root@k8s-master ~]#- 执行过程截图

- 拉取到的镜像内容如下

- 注意:kubeadm init工作流程

1、[preflight] 环境检查,拉取镜像(注意:拉取镜像是发生在这一步!!!)

2、[certs] 证书生成

3、[kubeconfig] kubeconfig文件生成 (kubeconfig文件是其他组件连接api-server所需要用到的文件;)

4、[kubelet-start] 生成kubelet配置文件并启动 (注意:/var/lib/kubelet/config.yaml)

5、[control-plane] 静态pod启动master组件,包括了etcd

6、[mark-control-plane] 给master节点打一个roles和污点

7、[bootstrap-token] 引导kubelet生成证书

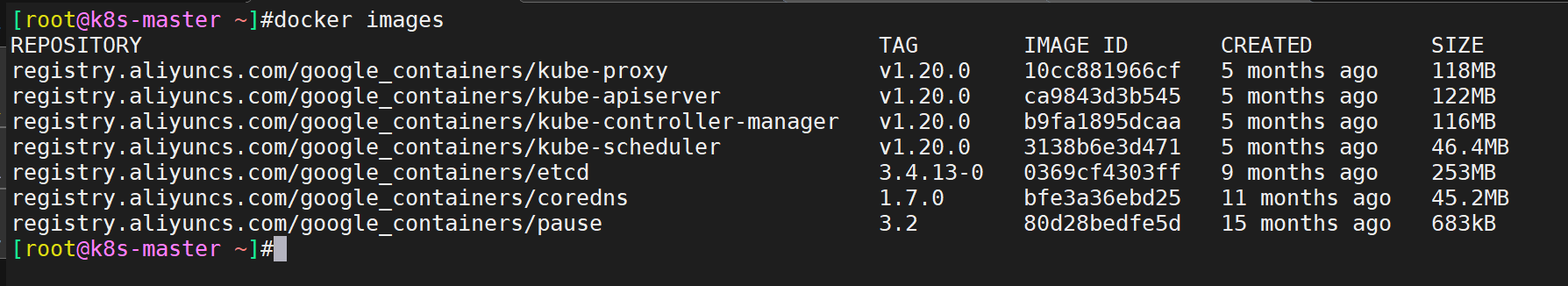

8、[addons] 安装coredns和kube-proxy- 注意:此时再次查看kubelet服务,发现已经启动成功了

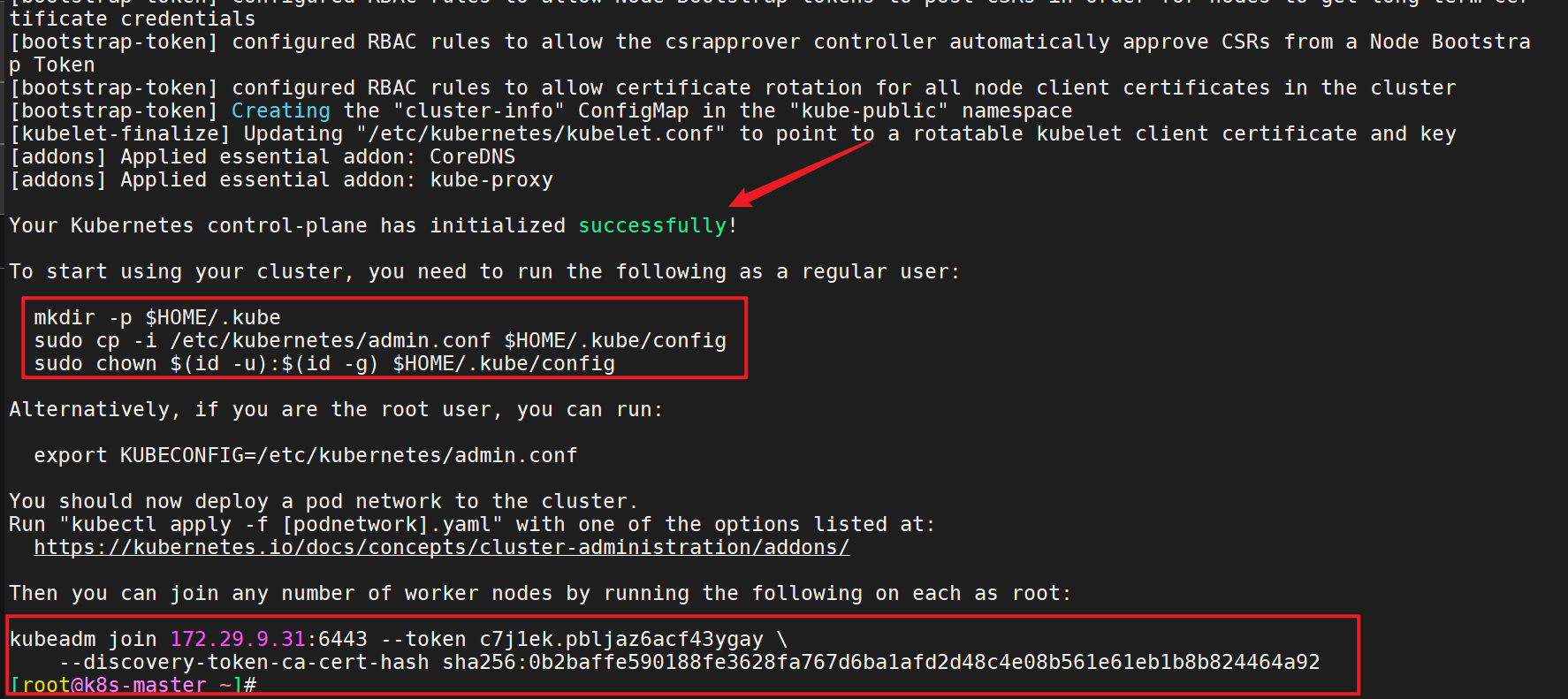

- 拷贝kubectl使用的连接k8s认证文件到默认路径

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

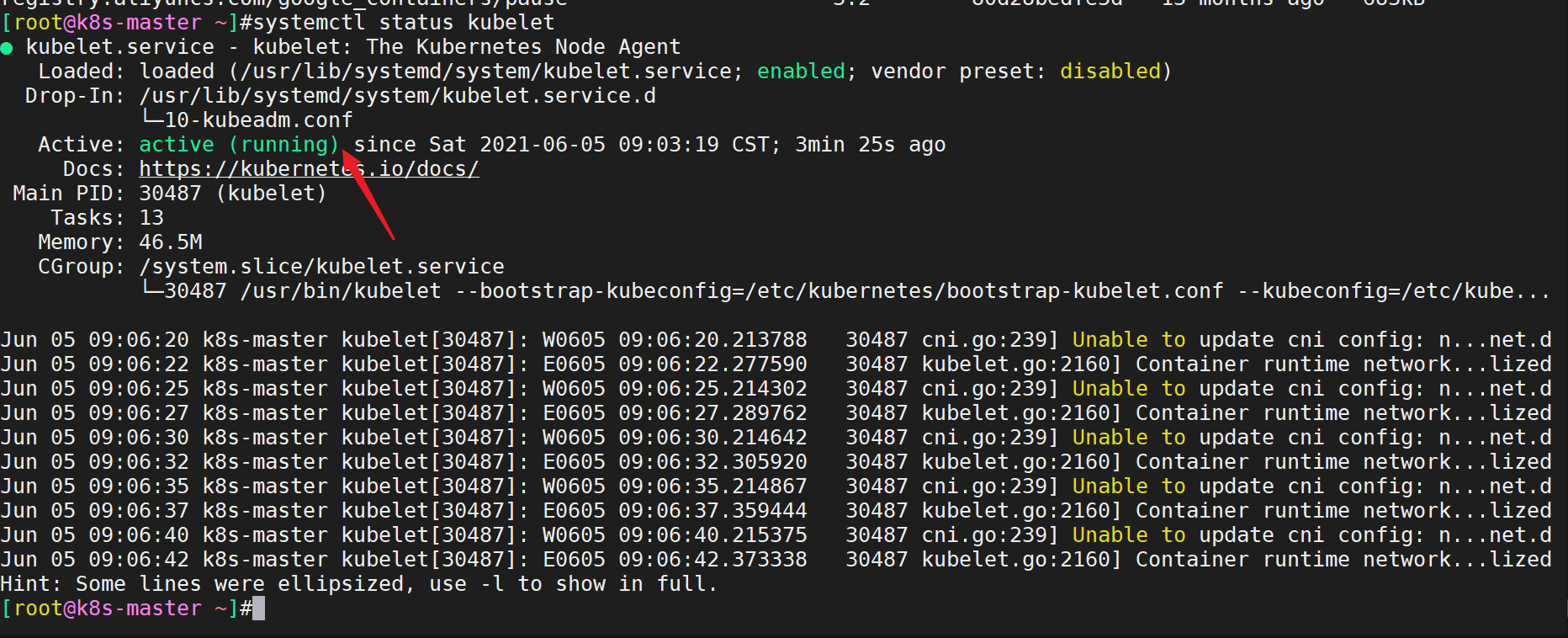

sudo chown $(id -u):$(id -g) $HOME/.kube/config- 生成了用于工作节点连接master的命令

初始化完成后,最后会输出一个join命令,先记住,下面用。

kubeadm join 172.29.9.31:6443 --token c7j1ek.pbljaz6acf43ygay \

--discovery-token-ca-cert-hash sha256:0b2baffe590188fe3628fa767d6ba1afd2d48c4e08b561e61eb1b8b824464a92- 注意:在拷贝kubectl所需的配置文件后,我们可以用

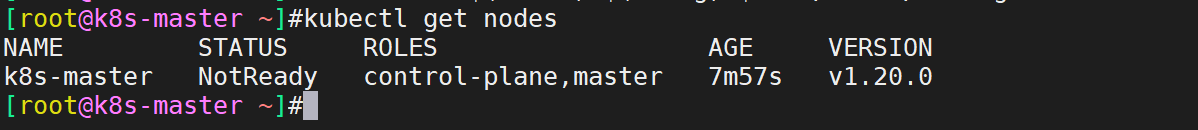

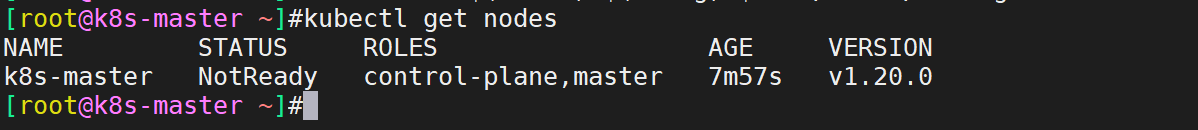

kubectl get nodes命令来查看master状态

[root@k8s-master ~]#kubectl get nodes

#注:由于网络插件还没有部署,还没有准备就绪 NotReady

- 注意 一般在执行了kubeadm int后,只要能看到如下就代表集群部署已经没什么问题了:

接下来我们来执行在node节点join命令。

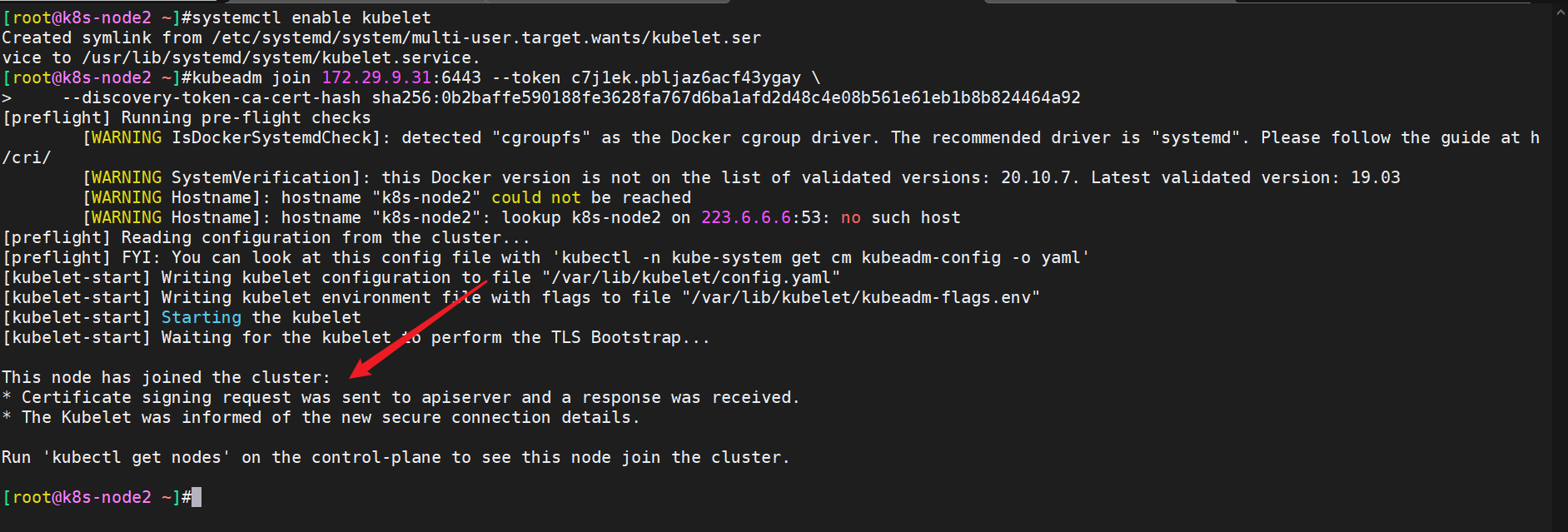

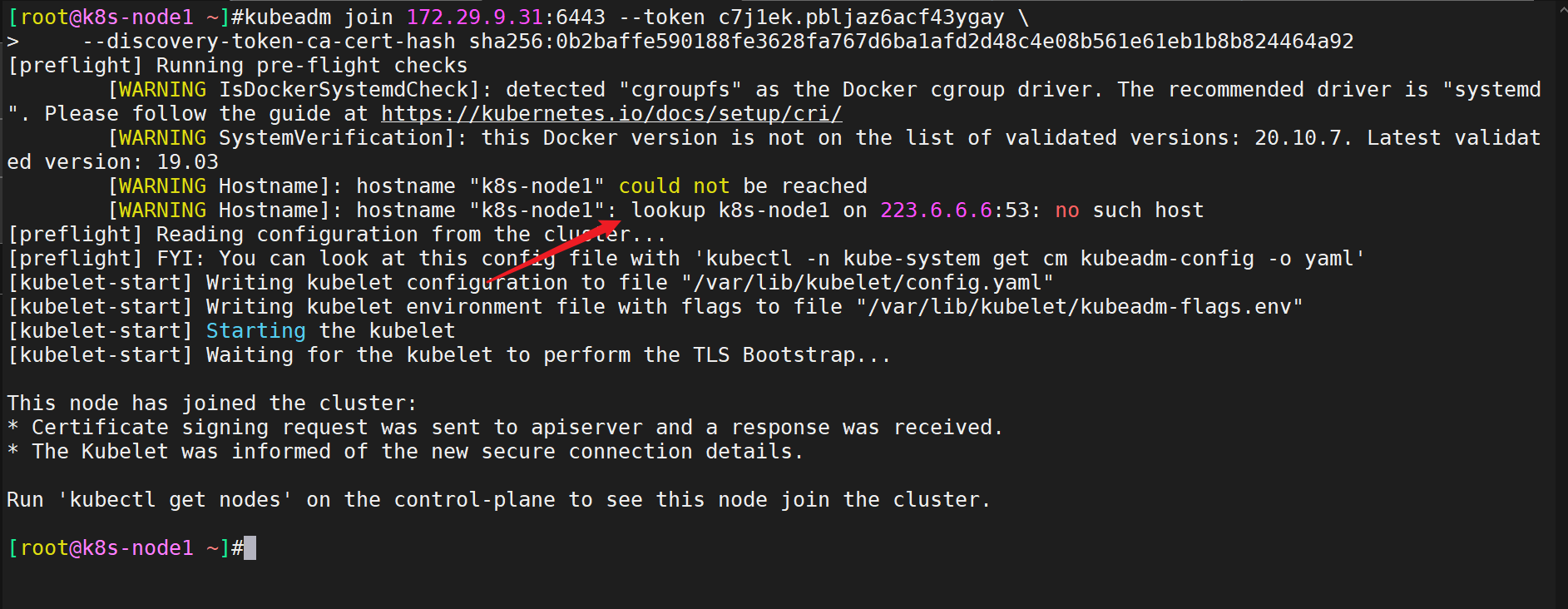

3.将Node节点加入到当前集群中(在node节点执行)

- 注意:如果当时忘记复制那个join命令了,该怎么办呢?

默认token有效期为24小时,当过期之后,该token就不可用了。这时就需要重新创建token,可以直接使用命令快捷生成:(注意:如果token还在有效期的话,那么就会打印出原来的token)

#在master节点上查看加入节点的命令:

[root@k8s-master ~]#kubeadm token create --print-join-command

kubeadm join 172.29.9.31:6443 --token c7j1ek.pbljaz6acf43ygay \

--discovery-token-ca-cert-hash sha256:0b2baffe590188fe3628fa767d6ba1afd2d48c4e08b561e61eb1b8b824464a92

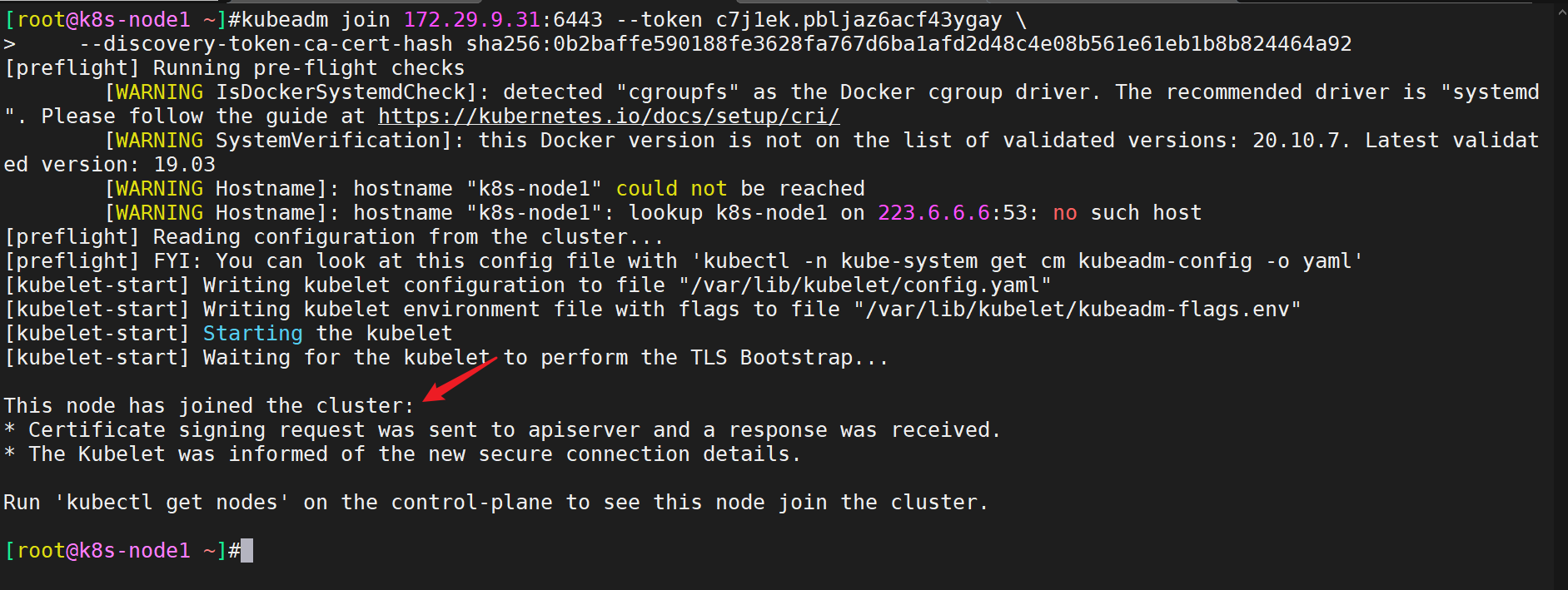

[root@k8s-master ~]- 开始join进群

#在2个node节点执行如下命令:

kubeadm join 172.29.9.31:6443 --token c7j1ek.pbljaz6acf43ygay \

--discovery-token-ca-cert-hash sha256:0b2baffe590188fe3628fa767d6ba1afd2d48c4e08b561e61eb1b8b824464a92- 执行过程截图如下

- 注意:这里报这个域名解析时没有任何影响的。(你不想警告的话,就在all节点均填一下域名解析配置)

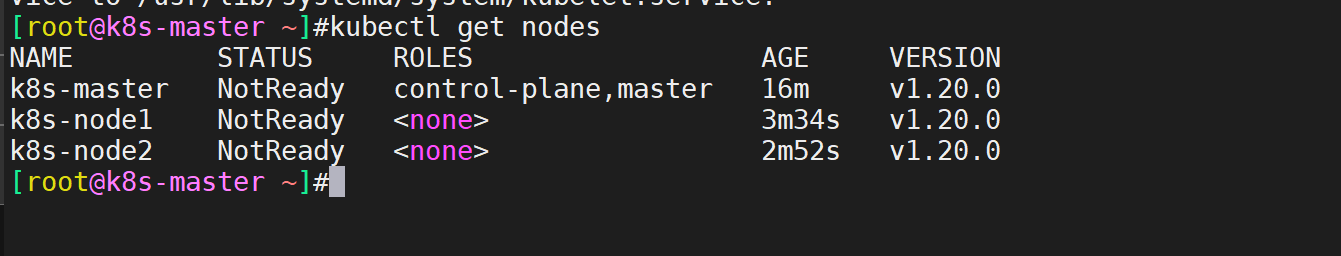

- 此时,再到master节点查看下集群状态,发现已经多出了2个node节点了。

后续步骤基本在master节点进行操作了,到此,node节点已配置完成。

下面,我们将配置网络组件-calico。

4.部署容器网络(CNI)-Calico(在master节点执行)

Calico是一个纯三层的数据中心网络方案,是目前Kubernetes主流的网络方案。(工作中:calico用的比较多)

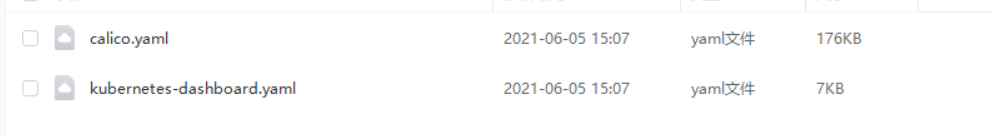

- 下载YAML:

wget https://docs.projectcalico.org/manifests/calico.yaml #这个需要科学上网,建议直接使用我这边提供的calico.yaml文件

- 编辑calicao的yaml文件

将下载好的calico.yaml文件传到/root/目录下,进行编辑:

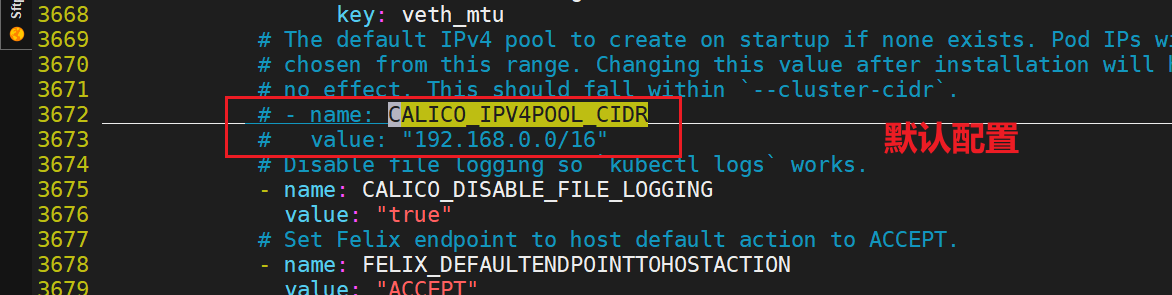

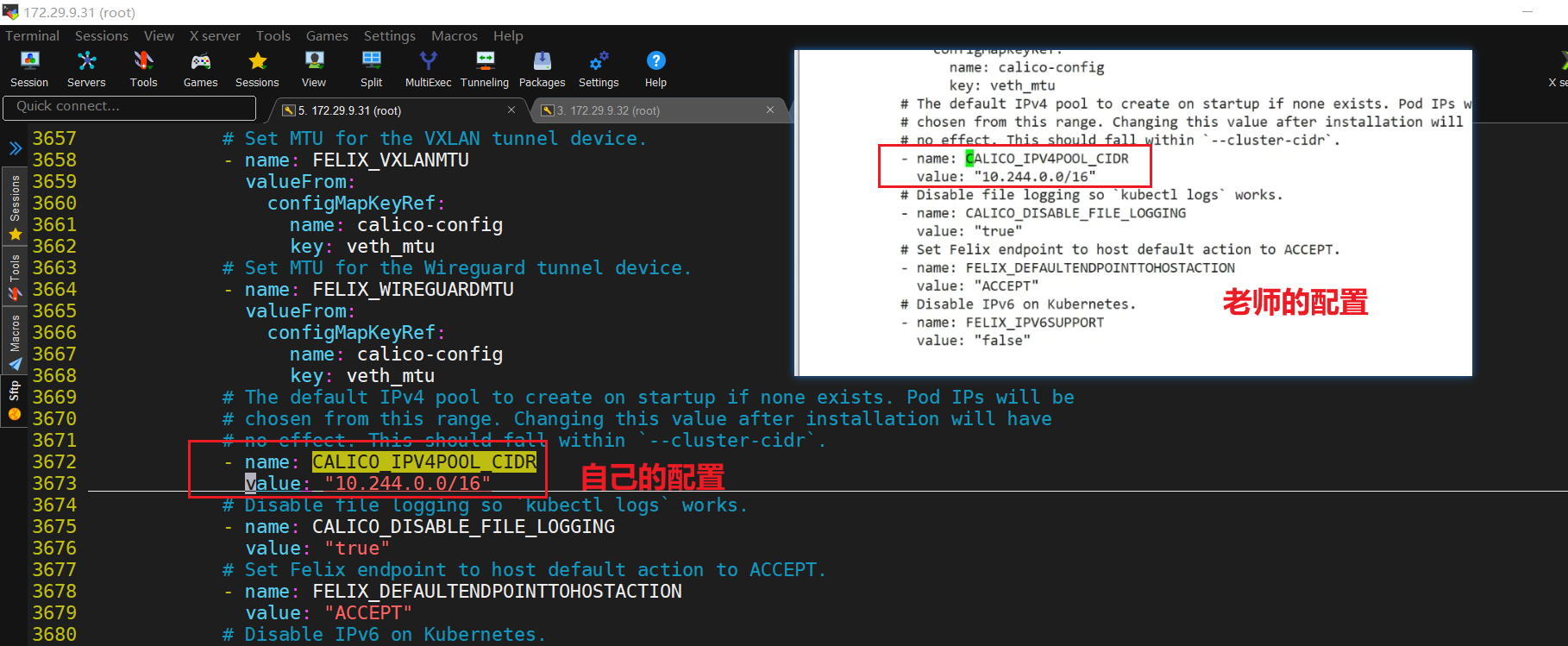

下载完后还需要修改里面定义Pod网络(CALICO_IPV4POOL_CIDR),与前面kubeadm init的 --pod-network-cidr指定的一样。

[root@k8s-master ~]#ll -h calico.yaml

-rw-r--r-- 1 root root 185K Jun 2 06:23 calico.yaml

[root@k8s-master ~]#vim calico.yaml

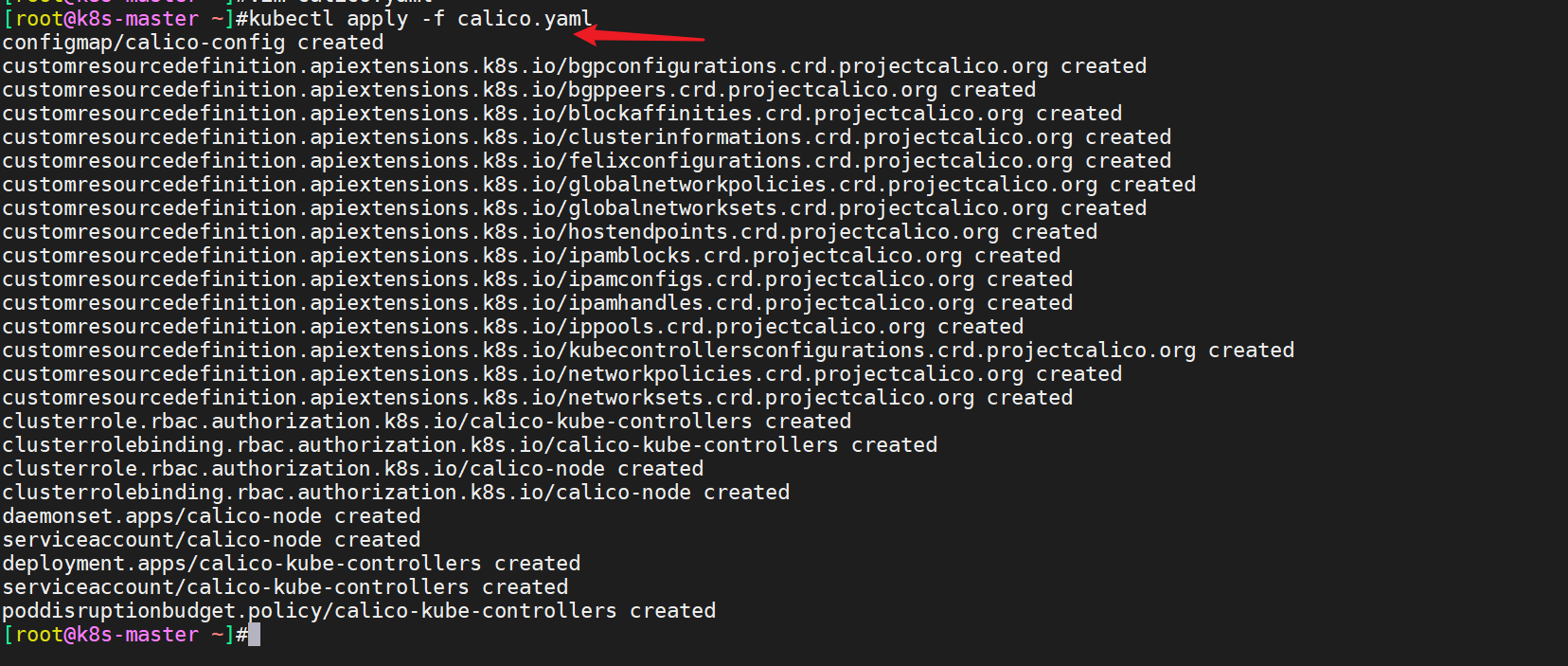

- 修改完后文件后,部署:

[root@k8s-master ~]#kubectl apply -f calico.yaml

- 验证

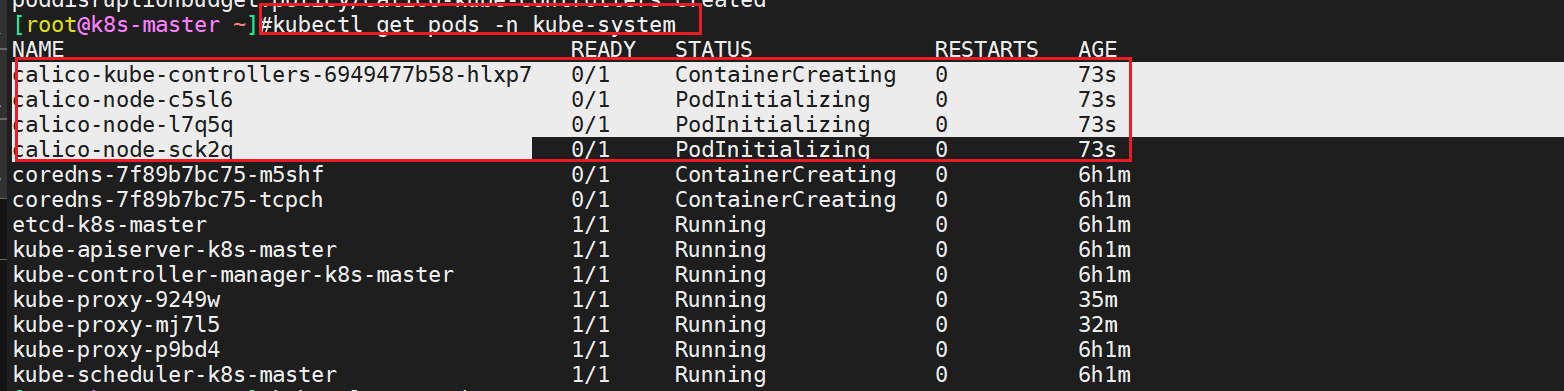

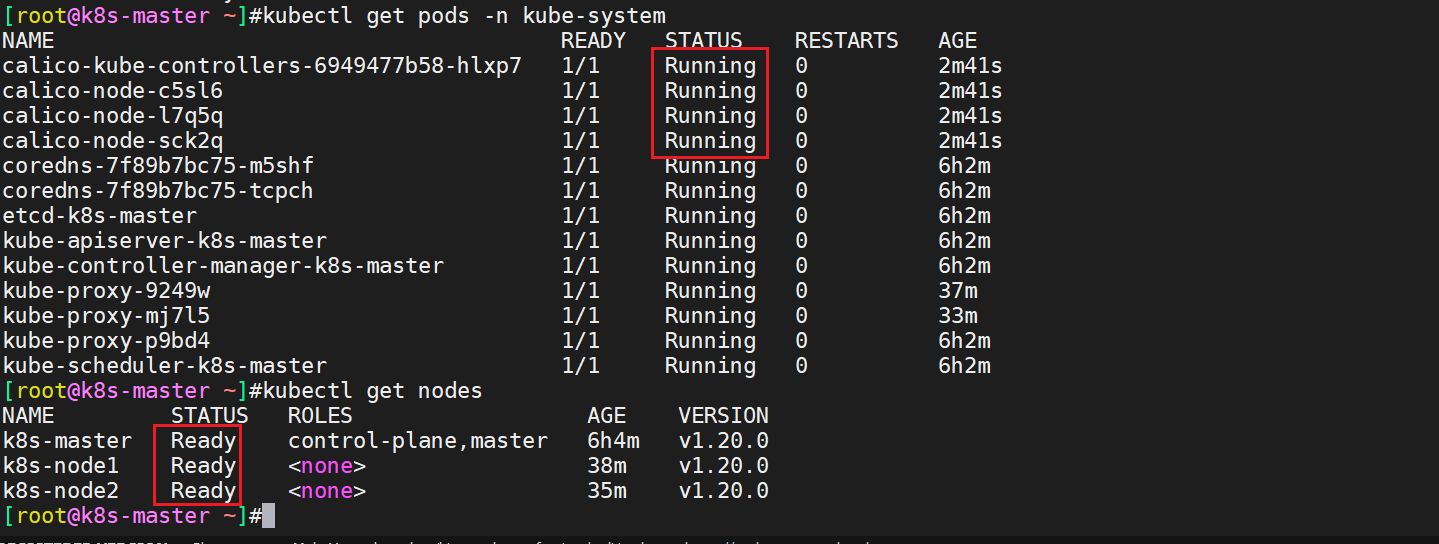

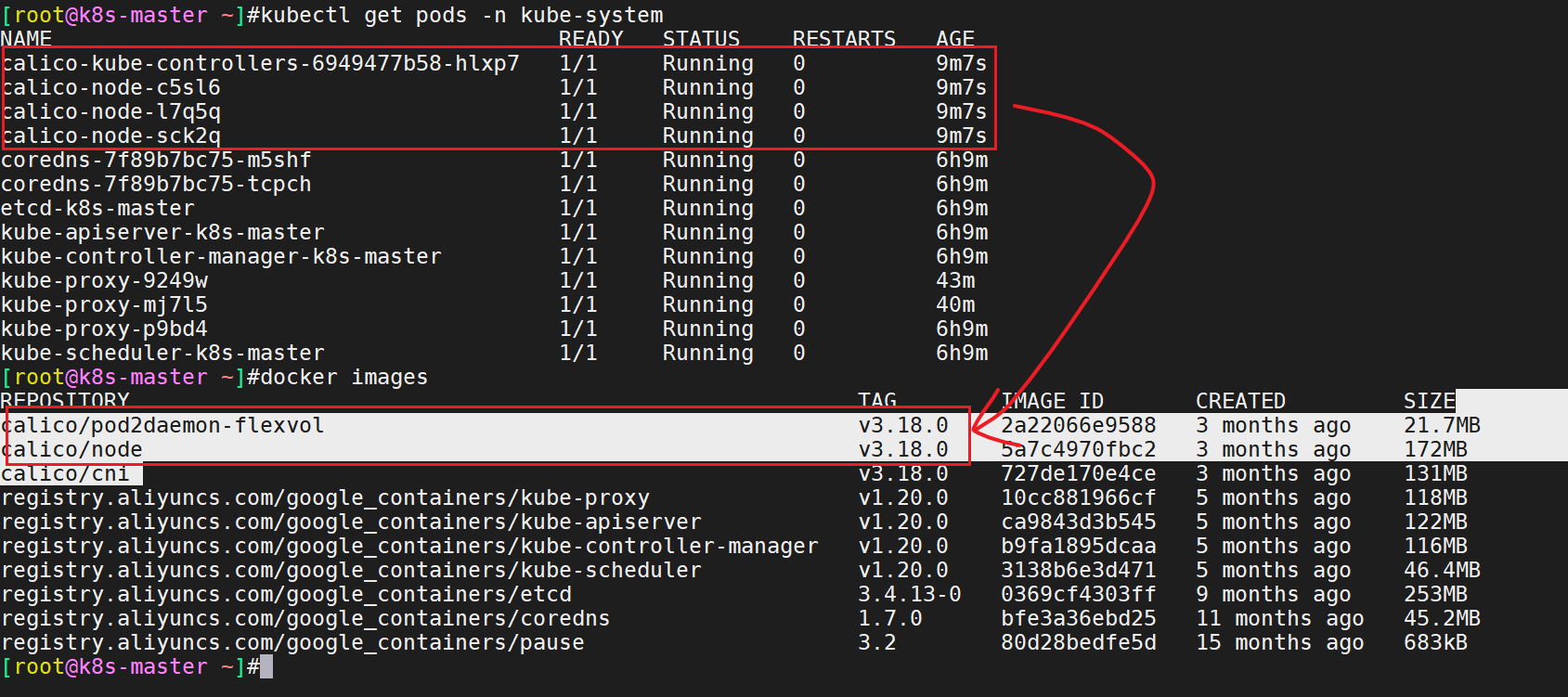

我们可以用如下命令来看一下这4个pod是否准备就绪,等Calico Pod都Running,节点也会准备就绪:

[root@k8s-master ~]#kubectl get pods -n kube-system

- 注意:或者我们可以把calico的镜像离线给下载下来,这样就省事儿了。

接下来,我们将部署一下web ui dashboard。

5.部署Web UI(Dashboard)(在master节点执行)

Dashboard是官方提供的一个UI,可用于基本管理K8s资源。 说实话:ui在工作汇总用的还是很少的;它这些功能只满足一些最基本的要求;企业的需求还是挺多的; ui这用来观察下集群的资源罢了;

- 下载

wget https://raw.githubusercontent.com/kubernetes/dashboard/v2.0.3/aio/deploy/recommended.yaml

#需要科学上网下载- 这里使用我下载好的就行

课件中文件名是:kubernetes-dashboard.yaml

这里手动上传kubernetes-dashboard.yaml文件到系统上:

- 修改yaml文件

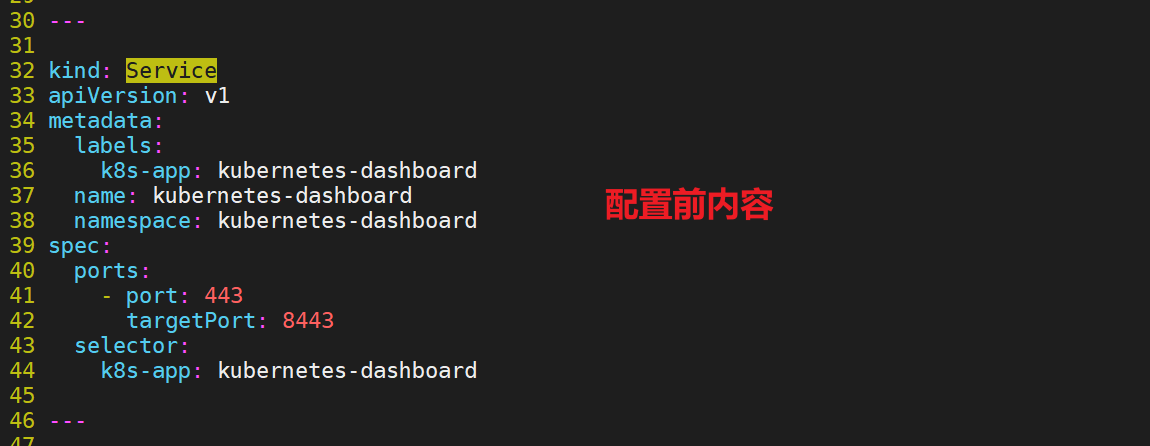

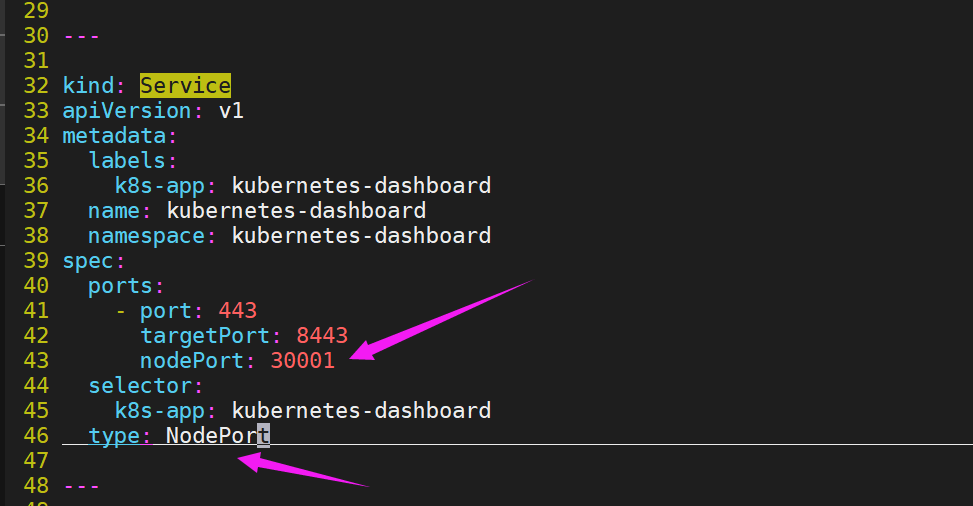

默认Dashboard只能集群内部访问,修改Service为NodePort类型,暴露到外部:

[root@k8s-master ~]#vim kubernetes-dashboard.yaml

vi recommended.yaml

...

kind: Service

apiVersion: v1

metadata:

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kubernetes-dashboard

spec:

ports:

- port: 443

targetPort: 8443

nodePort: 30001 #更改位置1

selector:

k8s-app: kubernetes-dashboard

type: NodePort #更改位置2

...

#说明:

只需要在service字段添加nodePort: 30001即可;

配置后内容:

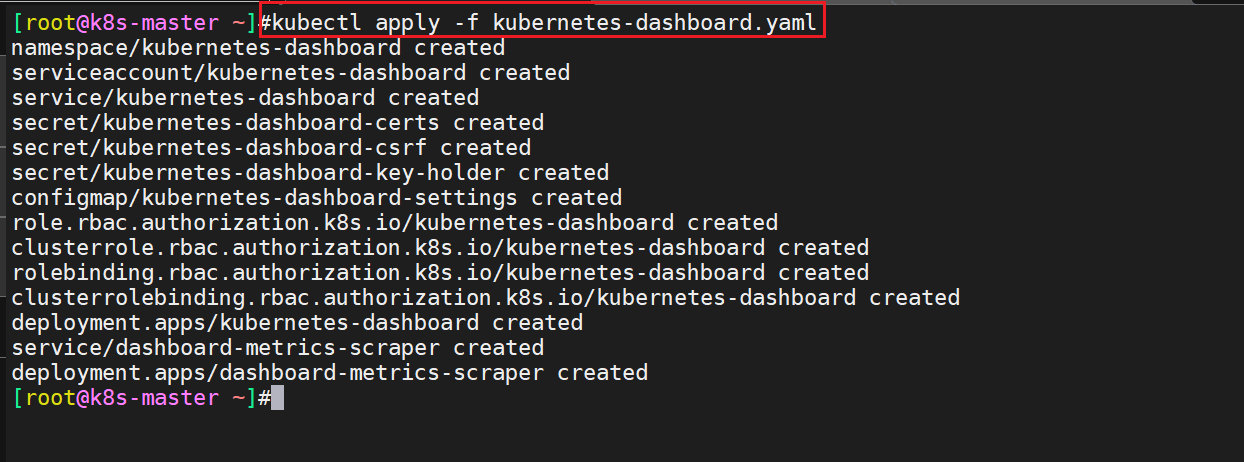

- 改完之后,我们直接apply一下就好:

[root@k8s-master ~]#kubectl apply -f kubernetes-dashboard.yaml

- 验证

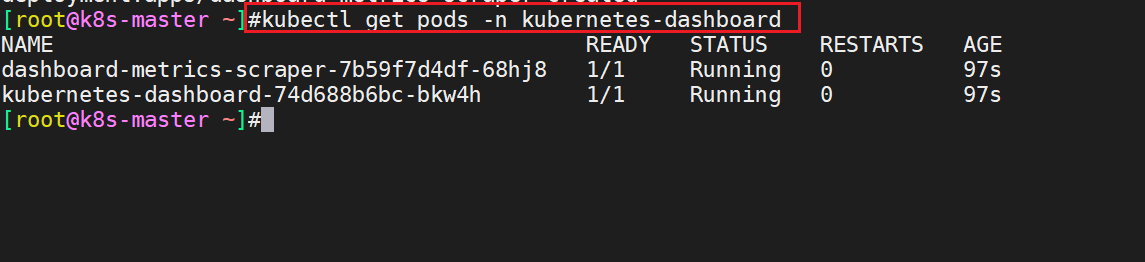

执行kubectl get pods -n kubernetes-dashboard命令:

[root@k8s-master ~]#kubectl get pods -n kubernetes-dashboard

NAME READY STATUS RESTARTS AGE

dashboard-metrics-scraper-7b59f7d4df-68hj8 1/1 Running 0 97s

kubernetes-dashboard-74d688b6bc-bkw4h 1/1 Running 0 97s

[root@k8s-master ~]#

#说明

dashboard-metrics-scraper-7b59f7d4df-68hj8(收集指标的容器)

kubernetes-dashboard-74d688b6bc-bkw4h(主容器),只要主容器启动了的话,我们就可以访问了;

#注意,这个kubernetes-dashboard叫做命名空间;

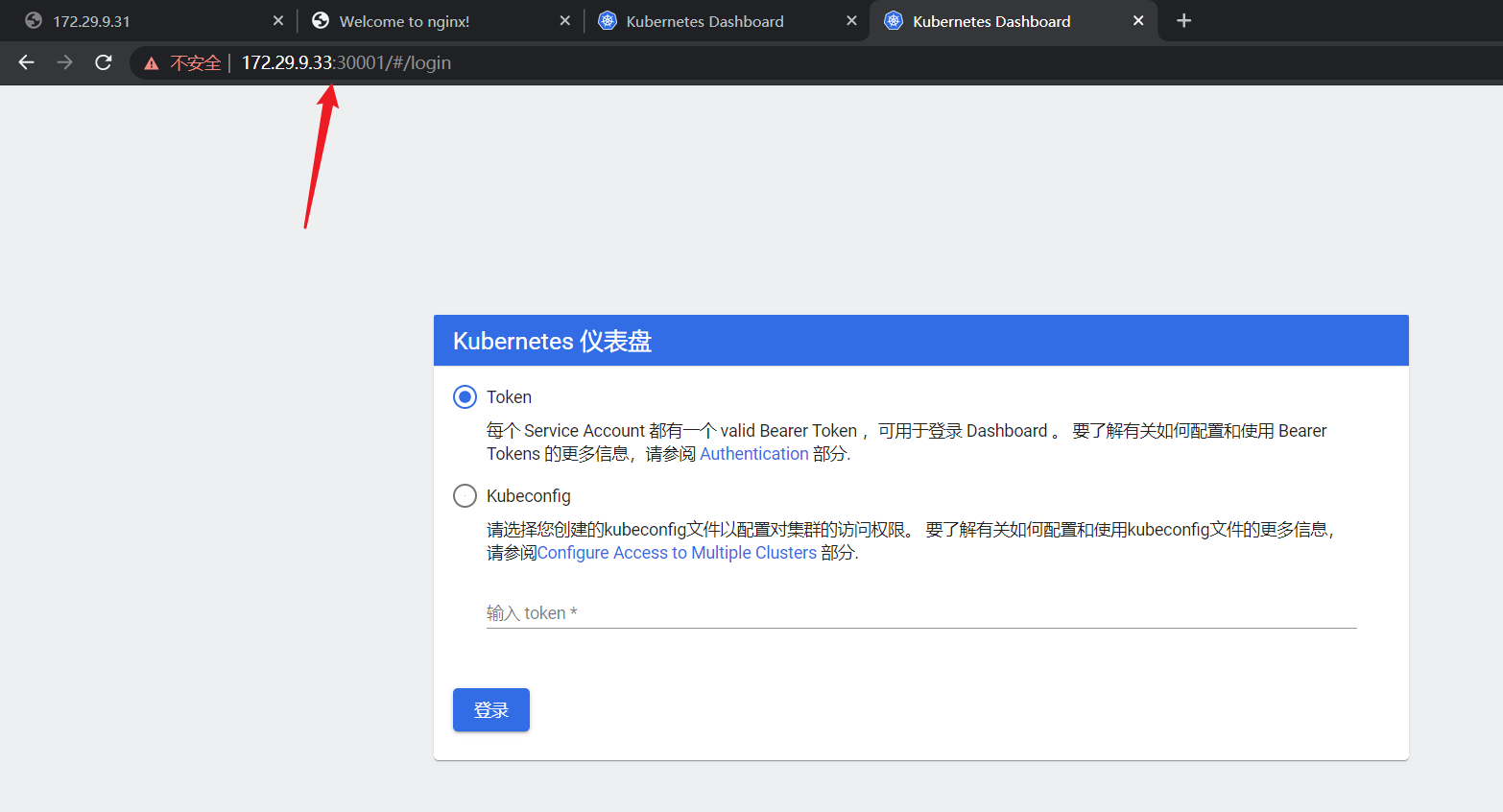

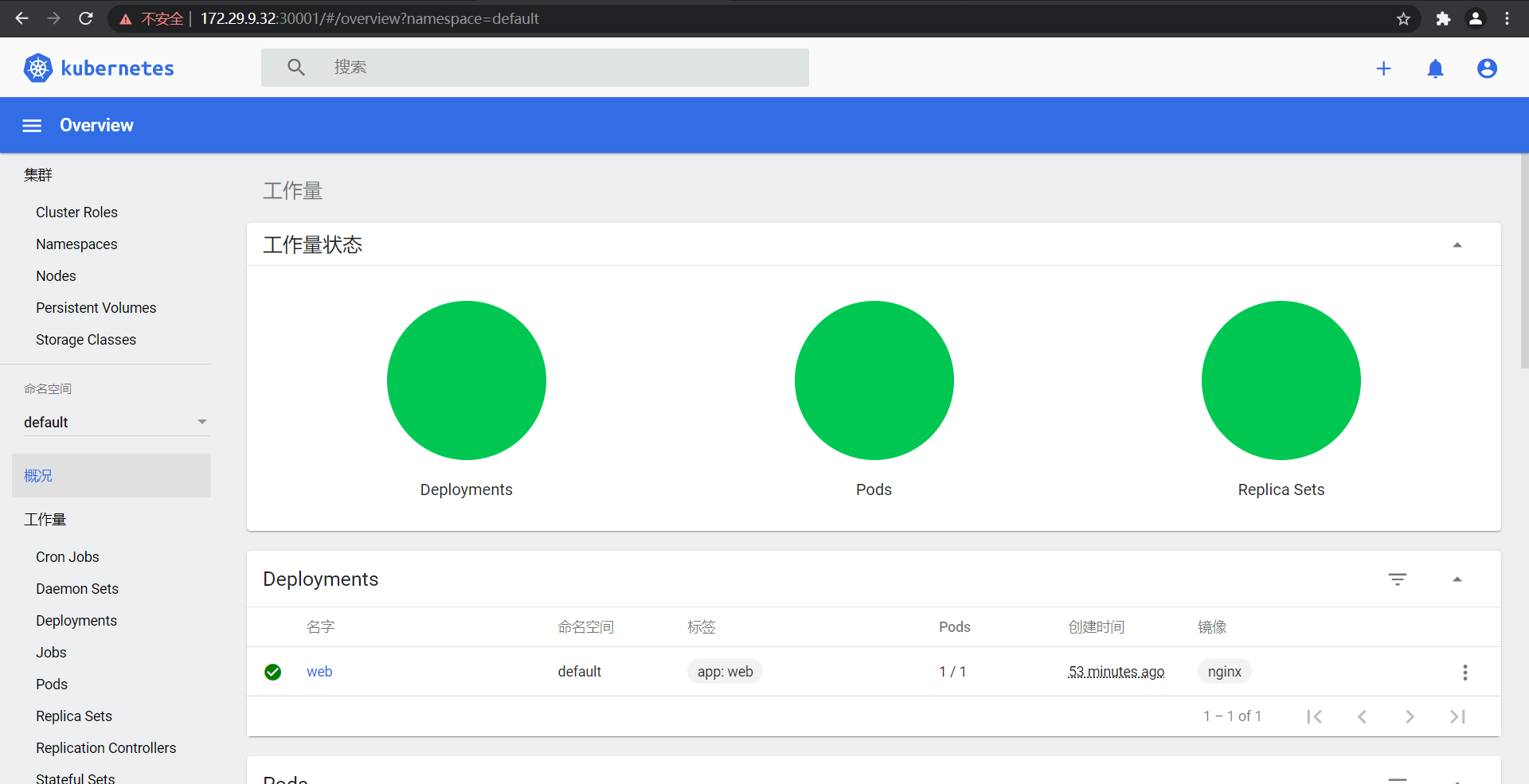

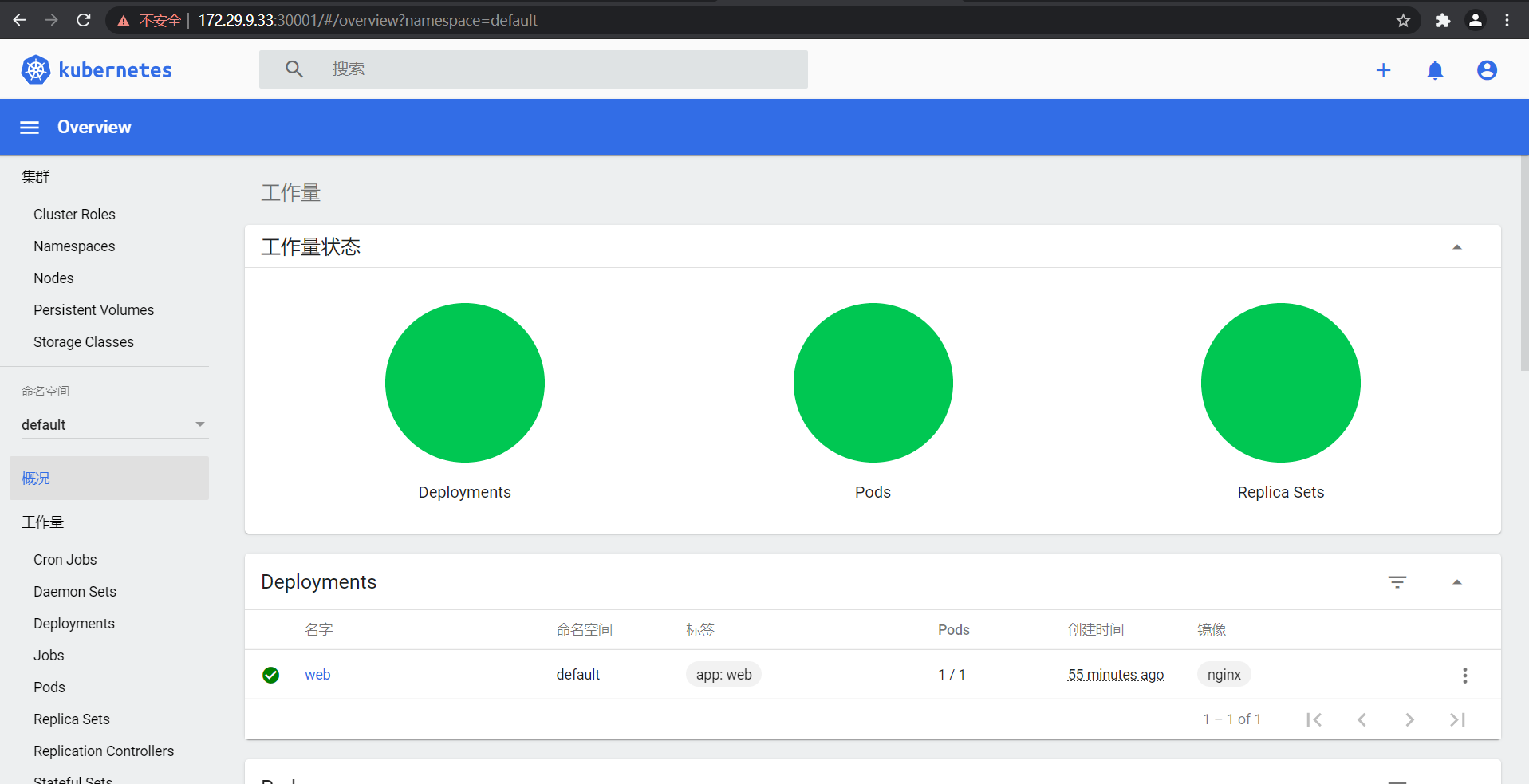

浏览访问

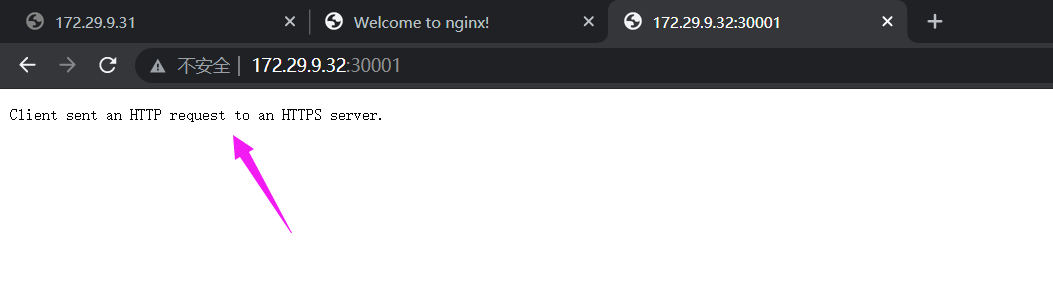

访问地址:https://NodeIP:30001

此时你访问集群内的任意ip:30001的话,就可以访问了ui界面了:

这里需要注意的是必须是https,如果是httpd的话,会报如下错误:

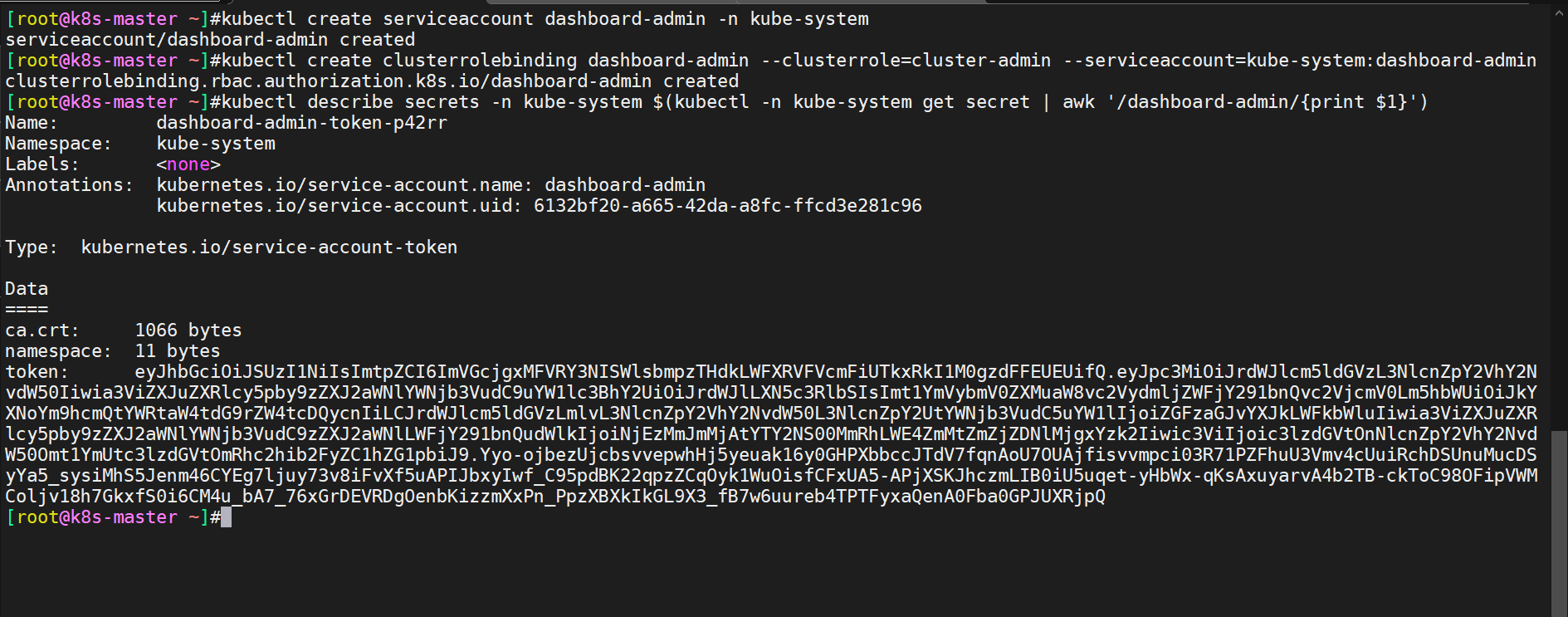

- 创建service account并绑定默认cluster-admin管理员集群角色:

# 创建用户

$ kubectl create serviceaccount dashboard-admin -n kube-system

# 用户授权

$ kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

# 获取用户Token

$ kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

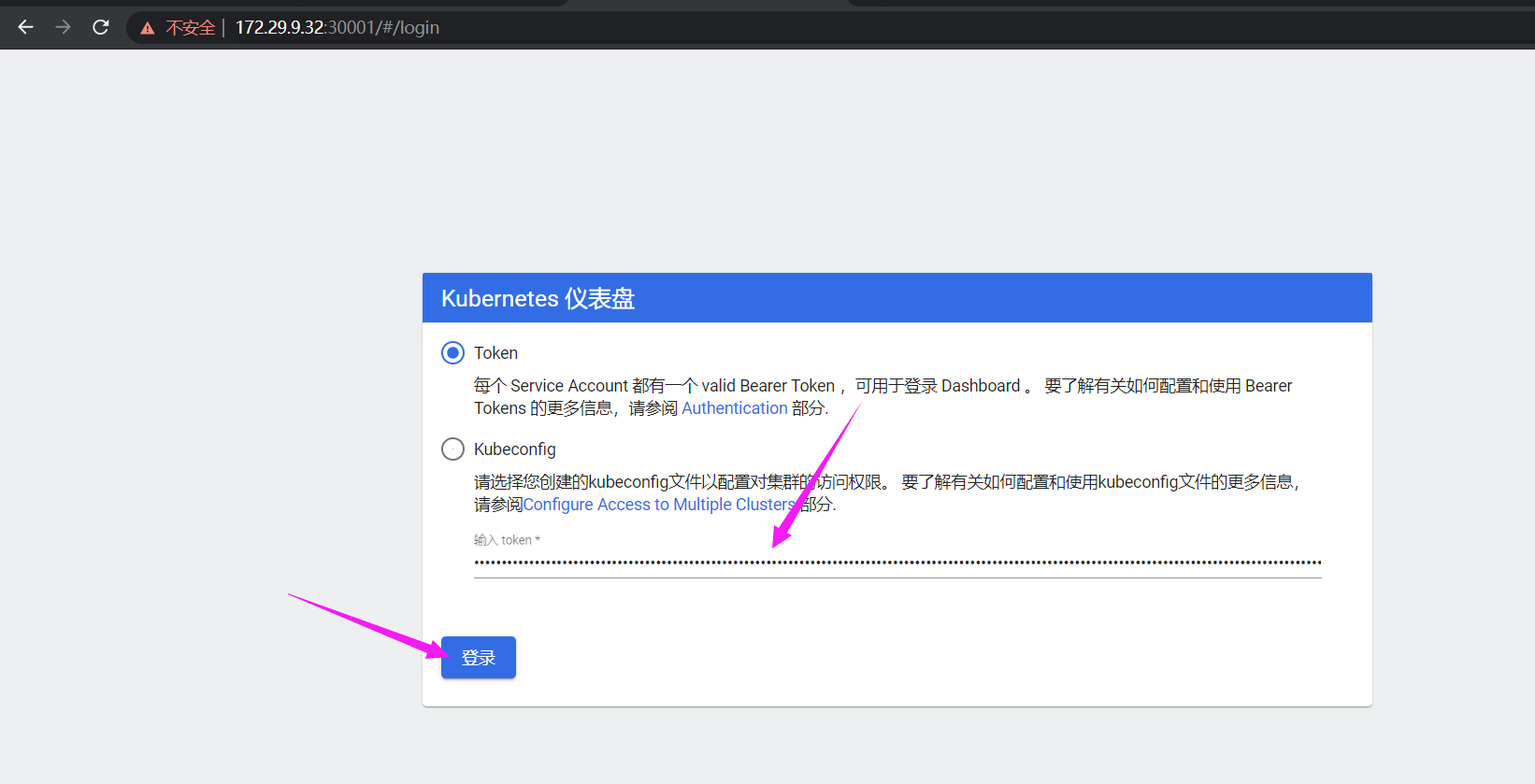

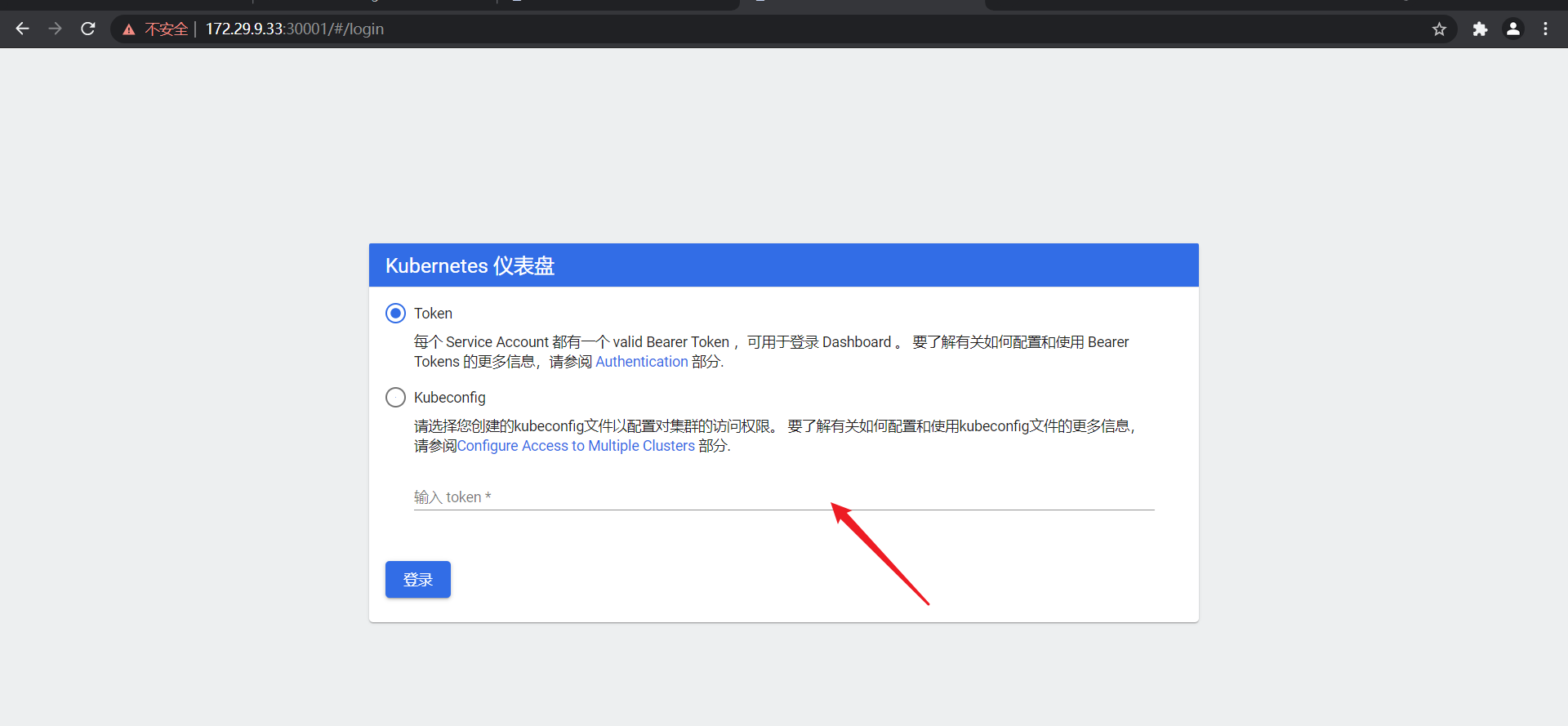

eyJhbGciOiJSUzI1NiIsImtpZCI6ImVGcjgxMFVRY3NISWlsbmpzTHdkLWFXRVFVcmFiUTkxRkI1M0gzdFFEUEUifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJrdWJlLXN5c3RlbSIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VjcmV0Lm5hbWUiOiJkYXNoYm9hcmQtYWRtaW4tdG9rZW4tcDQycnIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC5uYW1lIjoiZGFzaGJvYXJkLWFkbWluIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQudWlkIjoiNjEzMmJmMjAtYTY2NS00MmRhLWE4ZmMtZmZjZDNlMjgxYzk2Iiwic3ViIjoic3lzdGVtOnNlcnZpY2VhY2NvdW50Omt1YmUtc3lzdGVtOmRhc2hib2FyZC1hZG1pbiJ9.Yyo-ojbezUjcbsvvepwhHj5yeuak16y0GHPXbbccJTdV7fqnAoU7OUAjfisvvmpci03R71PZFhuU3Vmv4cUuiRchDSUnuMucDSyYa5_sysiMhS5Jenm46CYEg7ljuy73v8iFvXf5uAPIJbxyIwf_C95pdBK22qpzZCqOyk1WuOisfCFxUA5-APjXSKJhczmLIB0iU5uqet-yHbWx-qKsAxuyarvA4b2TB-ckToC98OFipVWMColjv18h7GkxfS0i6CM4u_bA7_76xGrDEVRDgOenbKizzmXxPn_PpzXBXkIkGL9X3_fB7w6uureb4TPTFyxaQenA0Fba0GPJUXRjpQ将用户token粘贴到如下位置:

实验现象成功,完美!

- 这边需要注意的是,如果从集群的另一个节点再次打开k8s ui的话,这边还需要再次输入token:

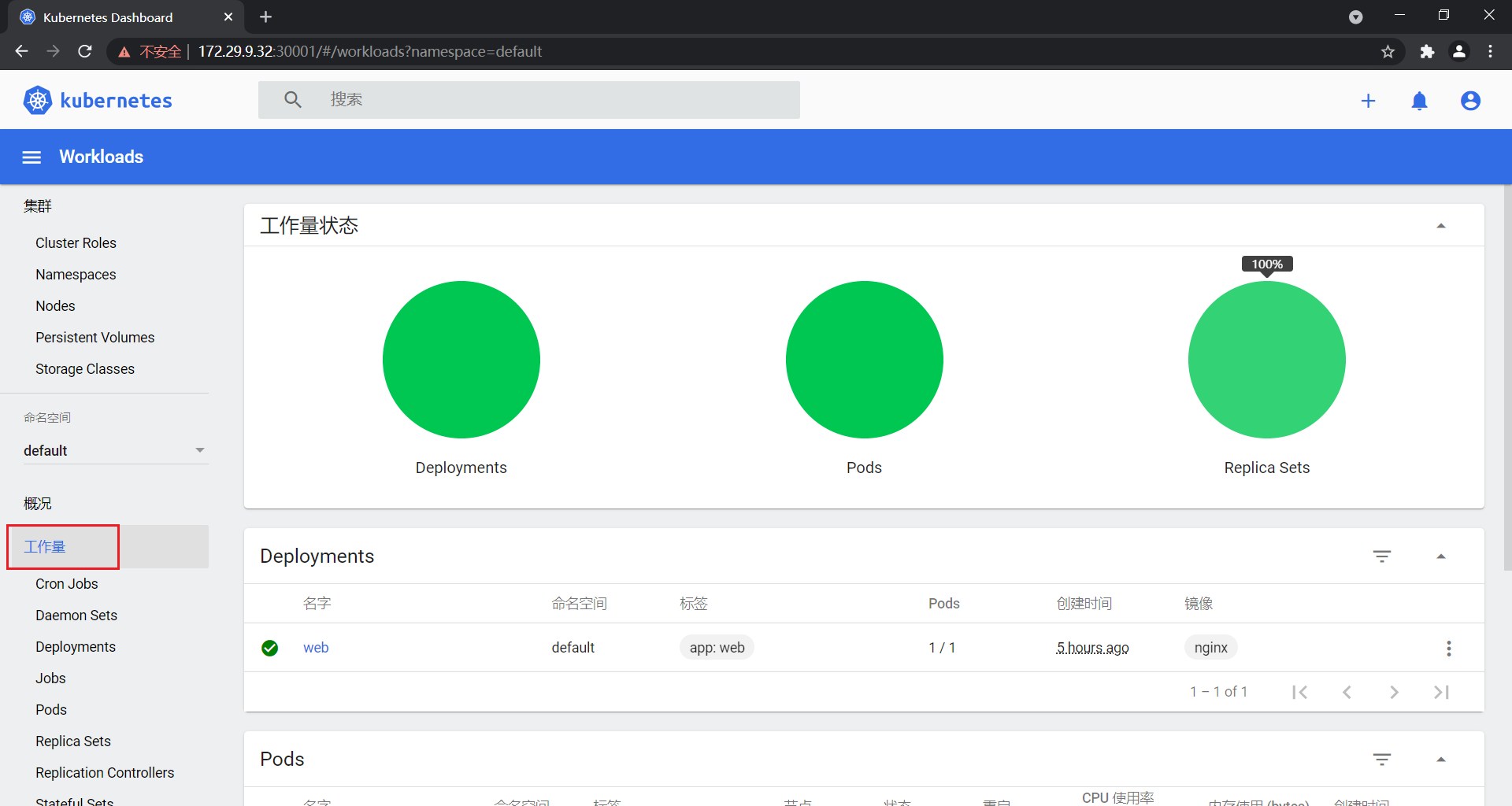

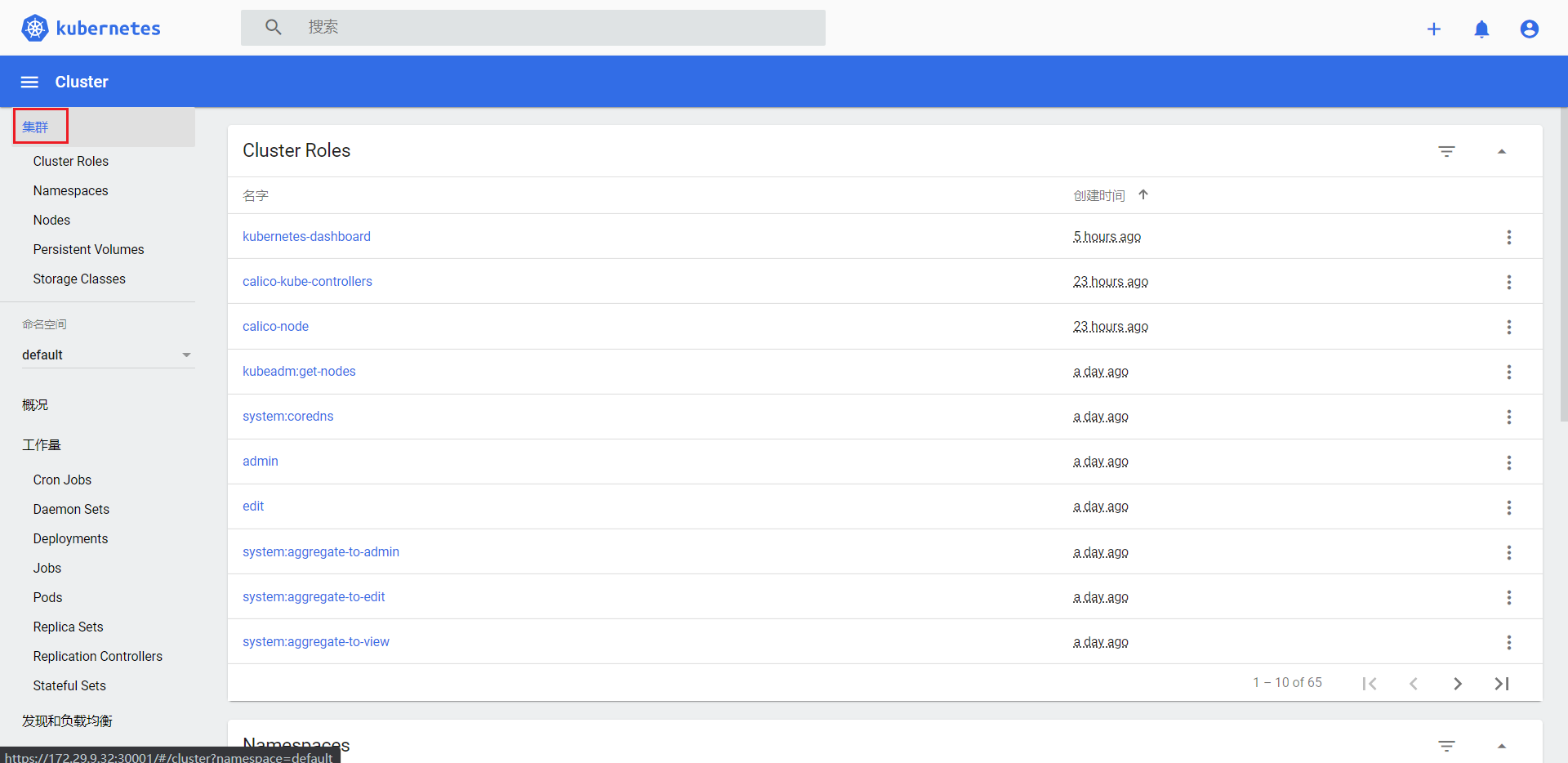

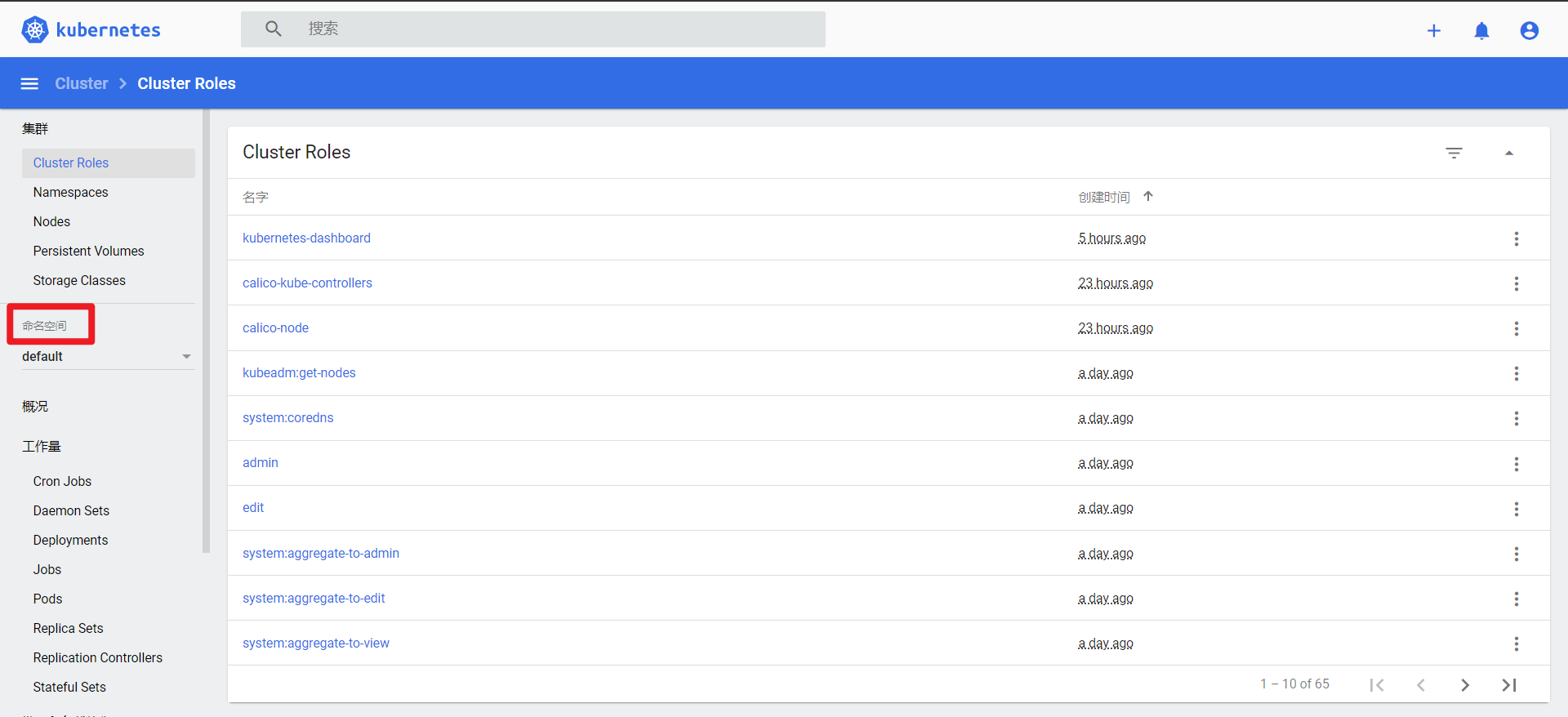

5.1 ui全貌

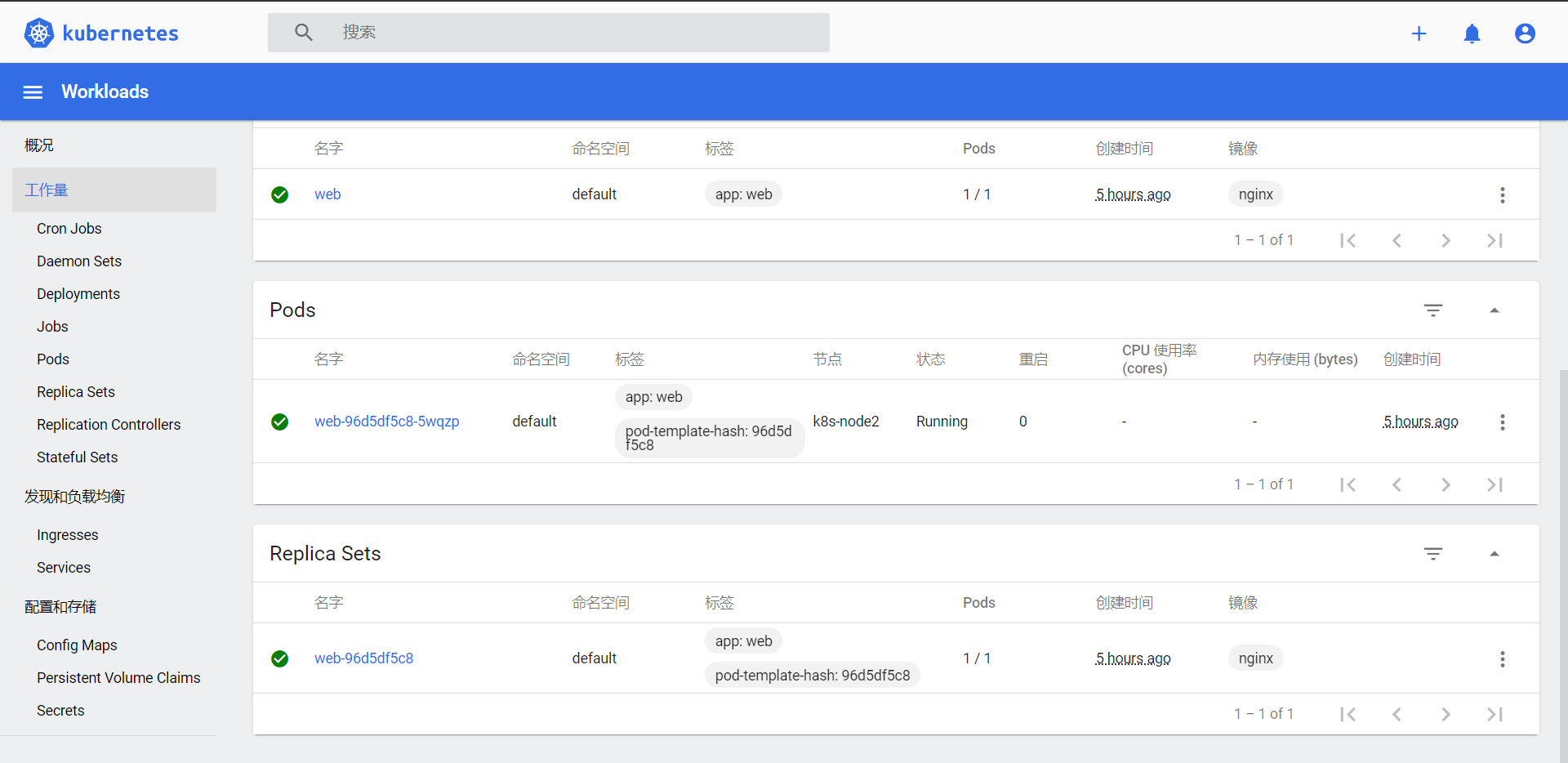

- 工作量

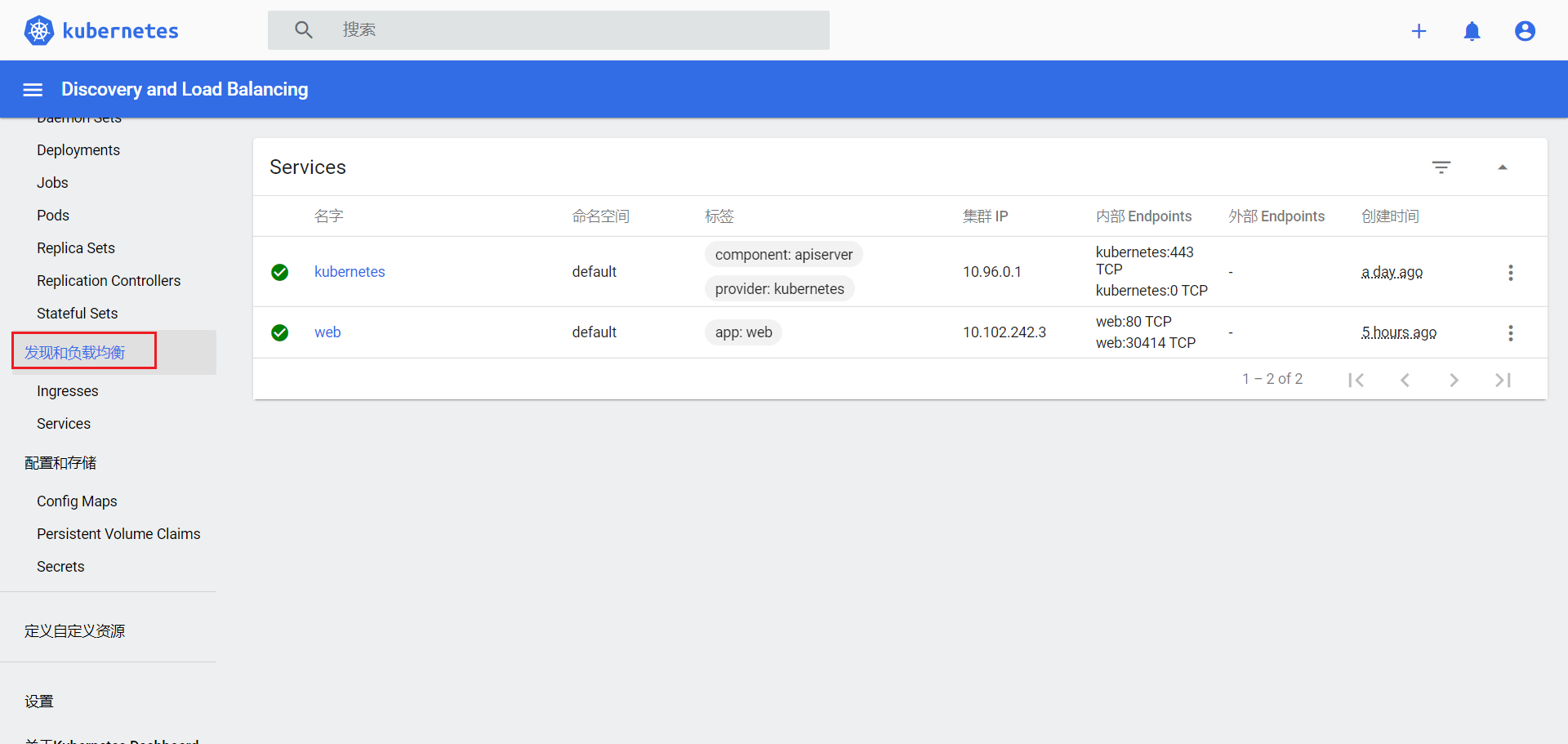

- 发现和负载均衡

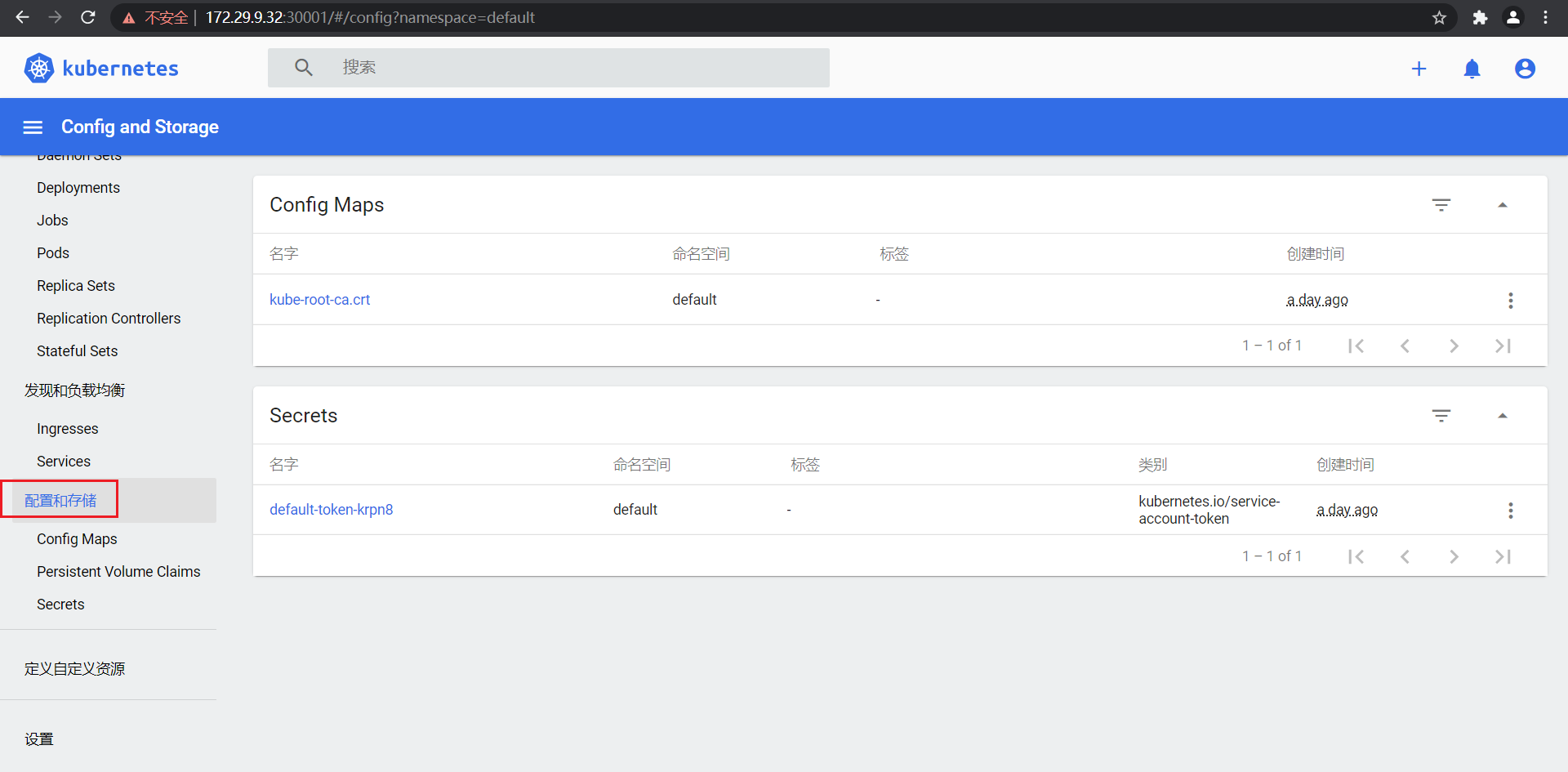

- 配置和存储

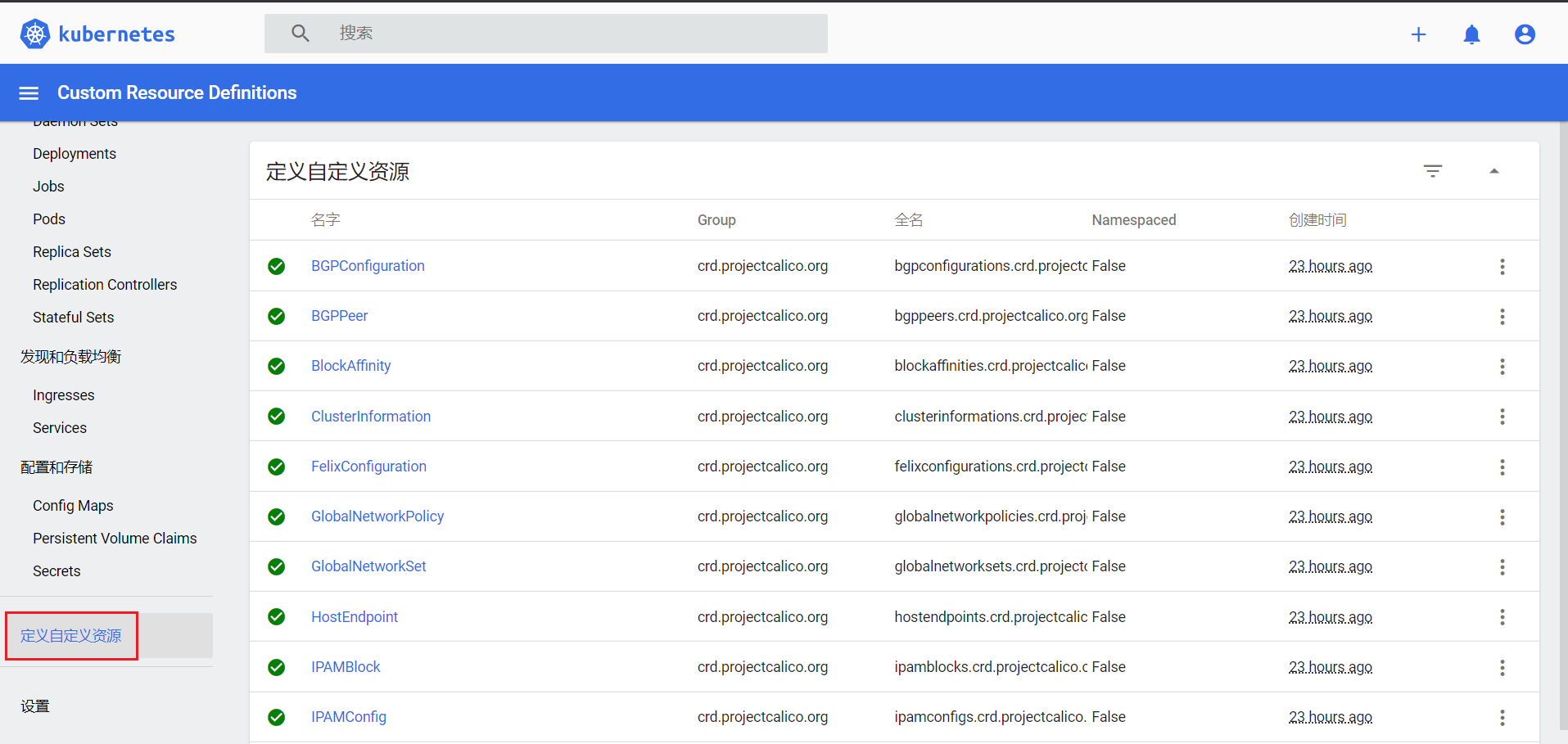

- 定义自定义资源

- 设置

- 集群

- 命名空间

5.2 这里有几个好的功能可以介绍给你

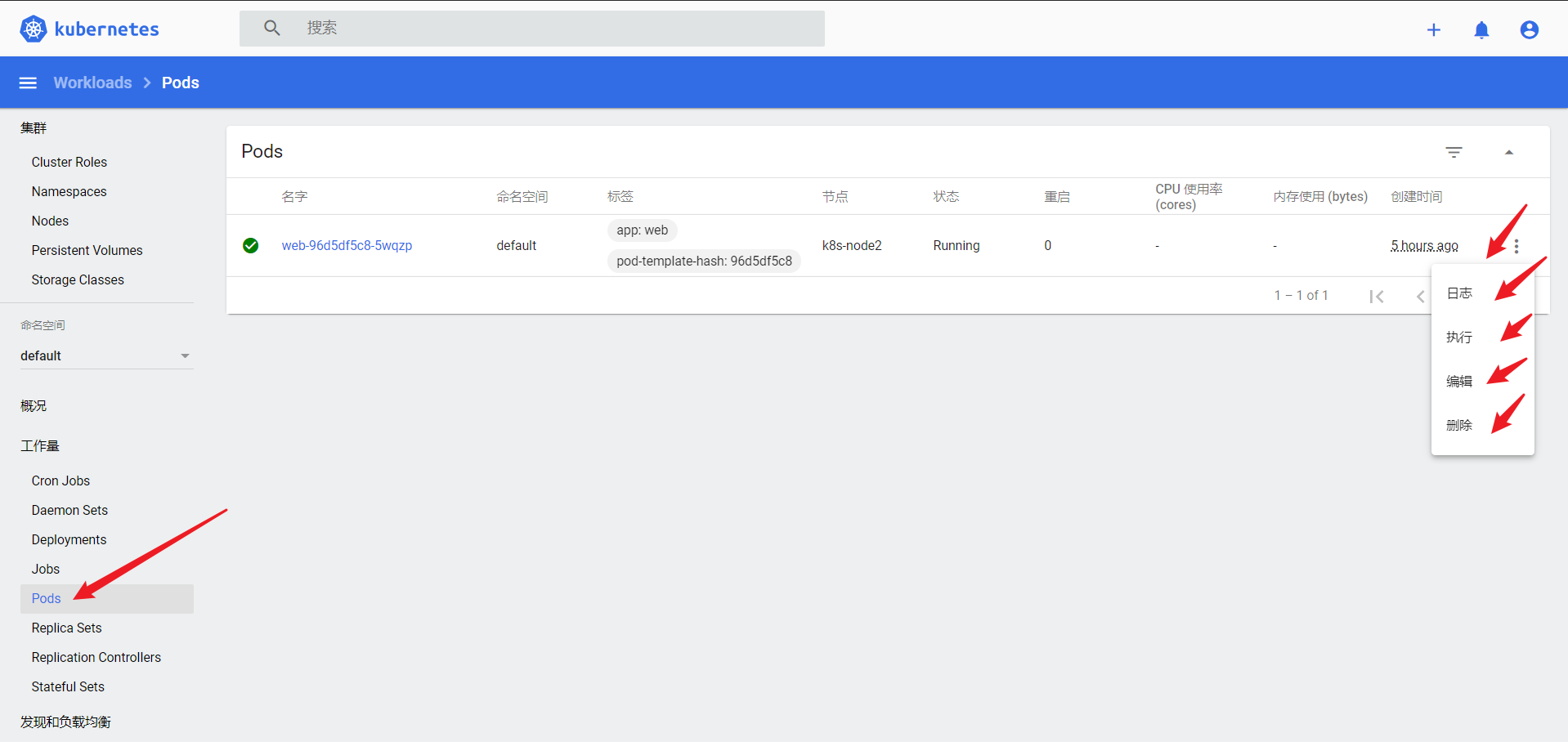

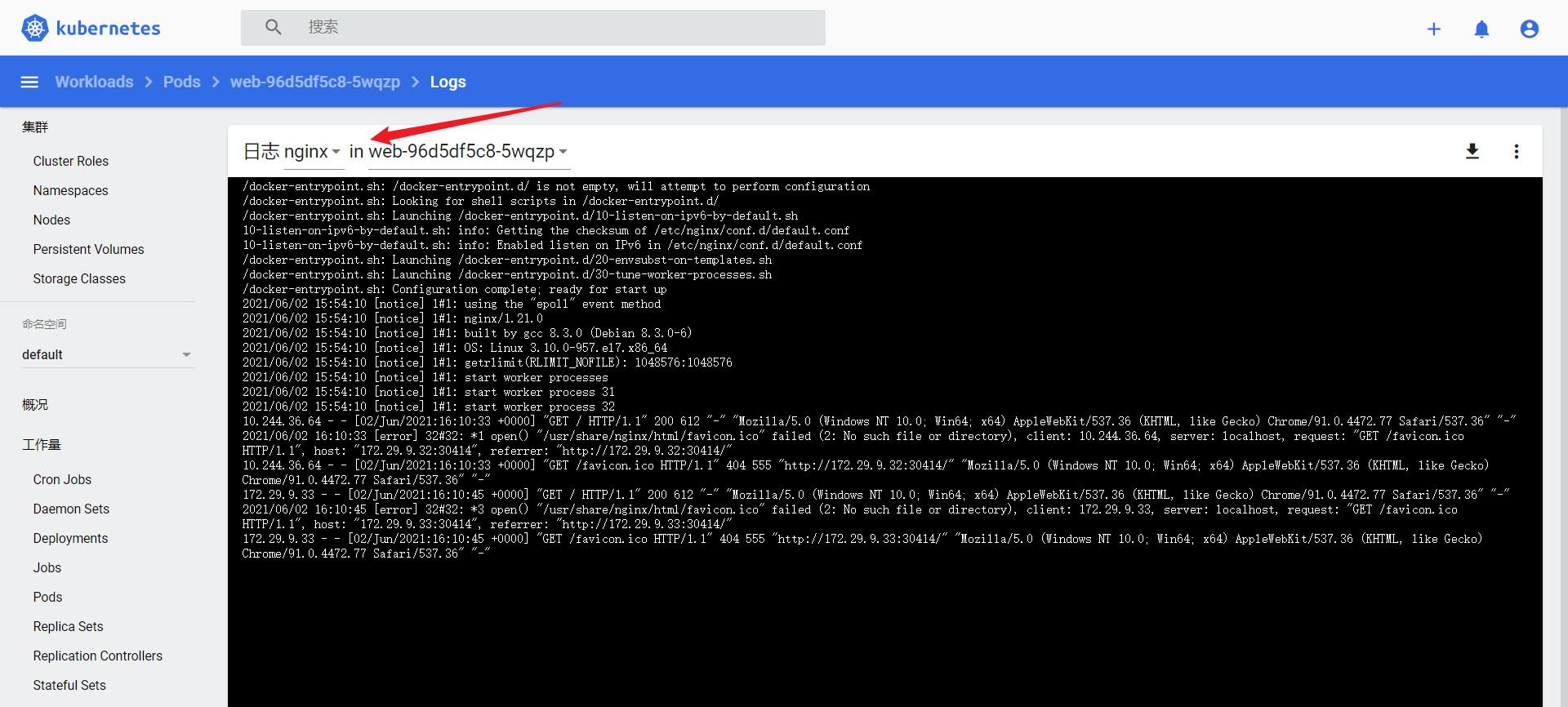

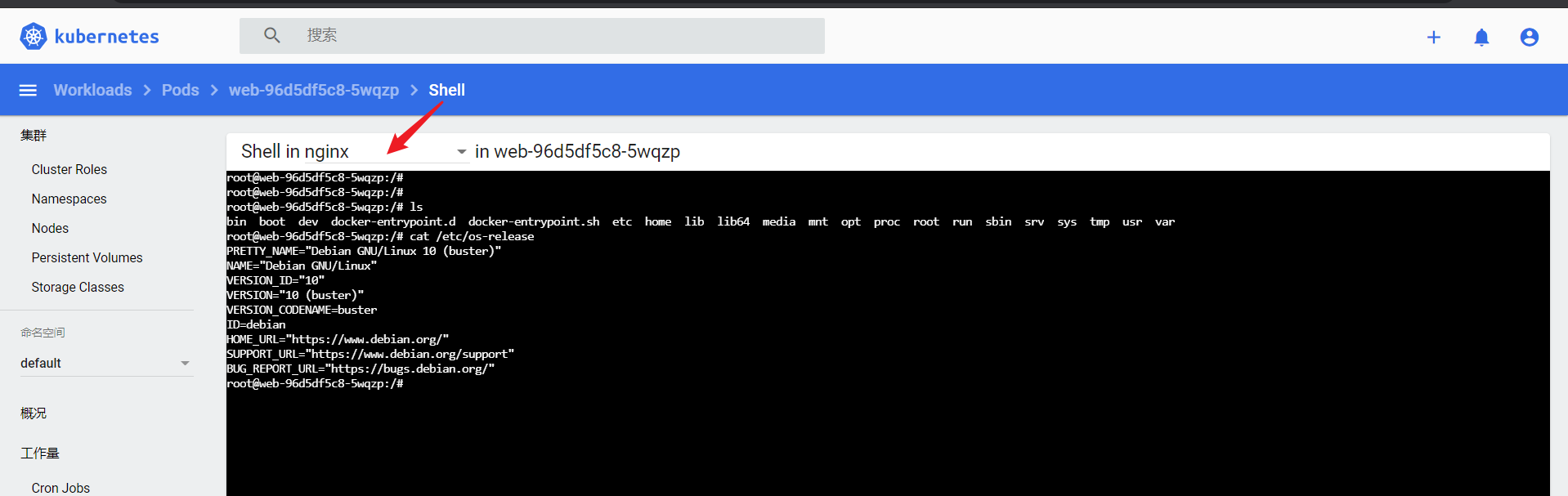

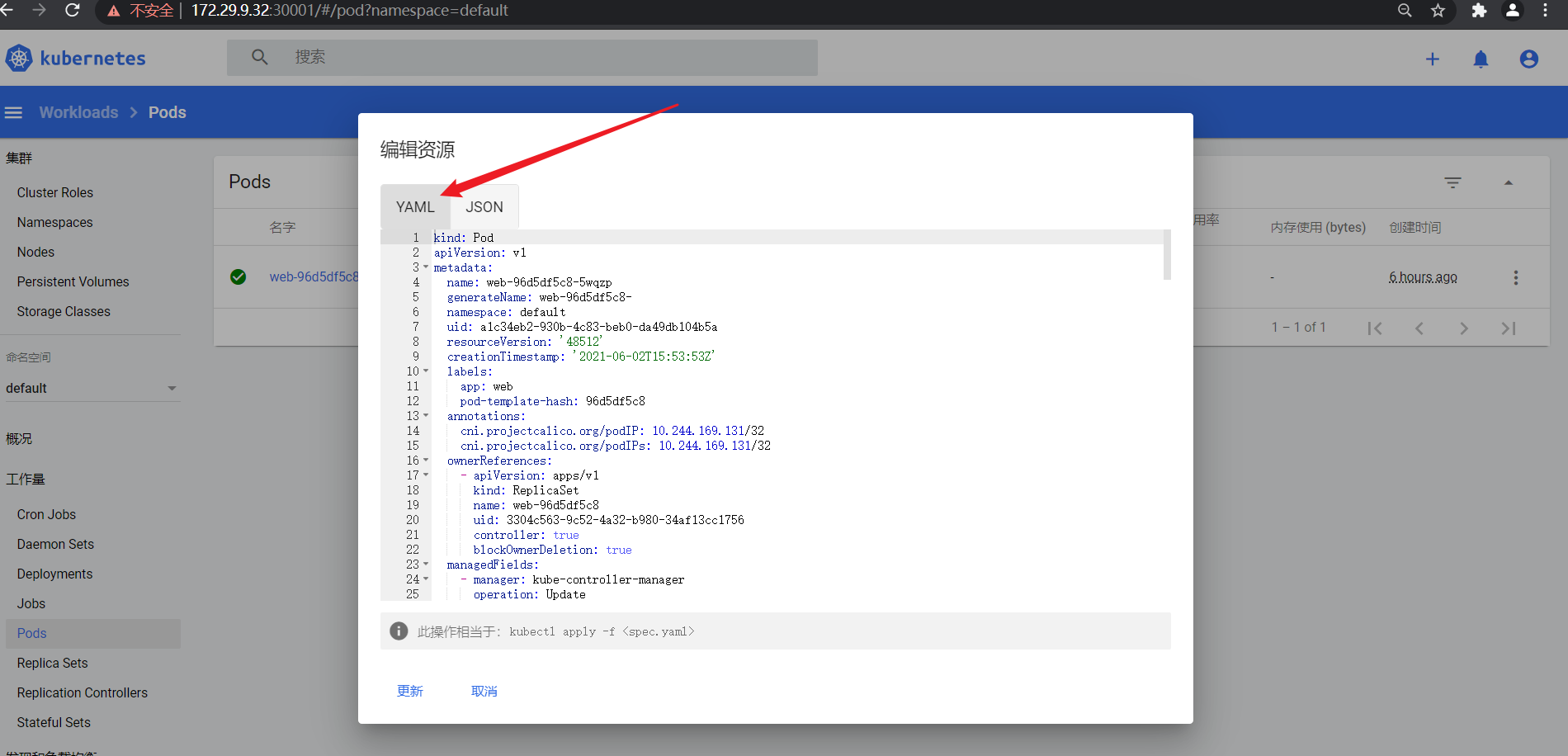

- 这里pods,可以进去到容器终端里面去:

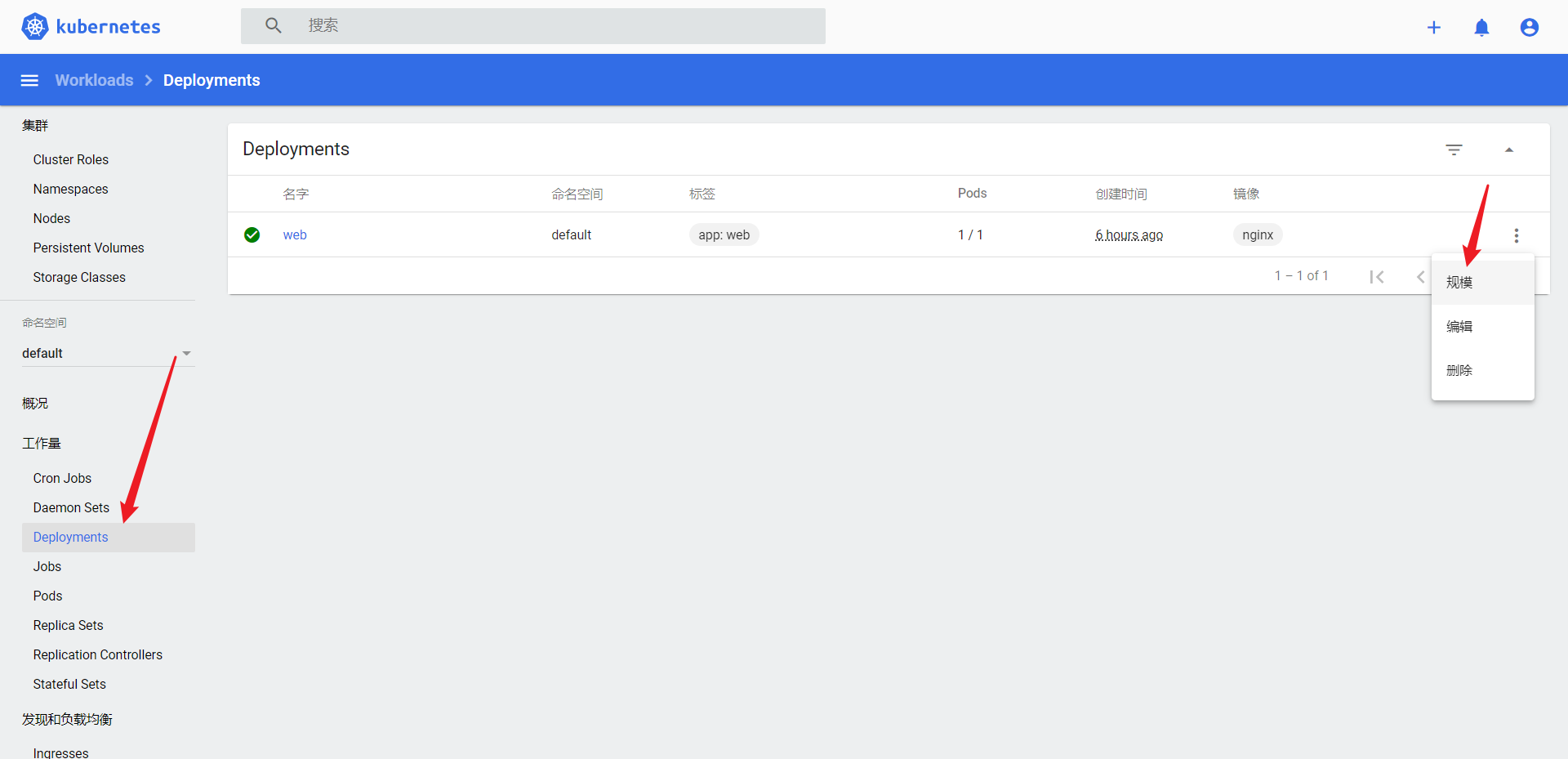

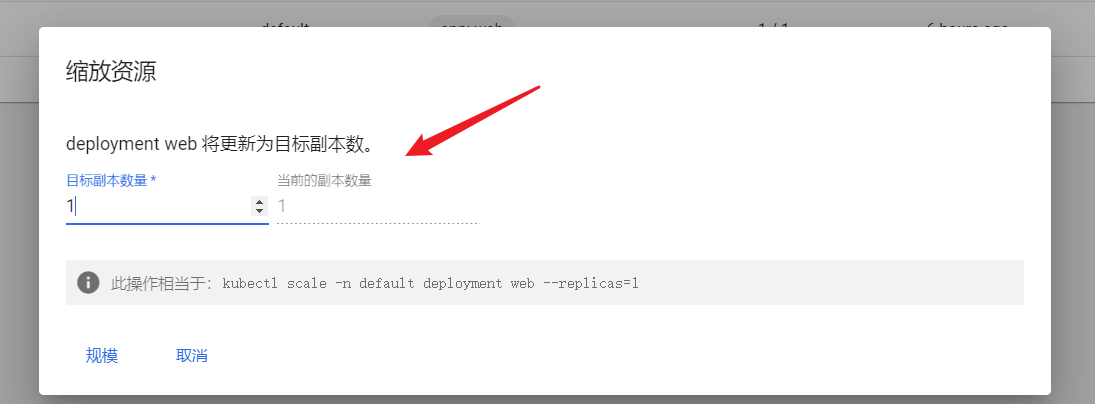

- deployment

接下来,我们启一个pod做下测试,看看效果。

6.测试:牛刀小试,快速部署一个网站(在master节点执行)

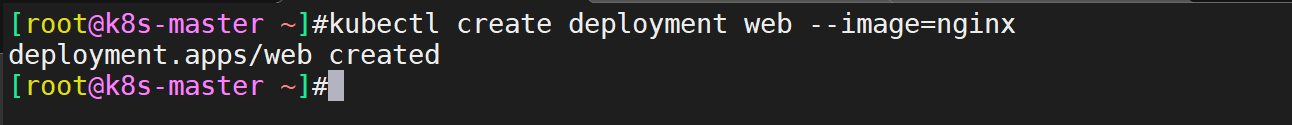

1、使用Deployment控制器部署镜像:

[root@k8s-master ~]#kubectl create deployment web --image=nginx

deployment.apps/web created

[root@k8s-master ~]#

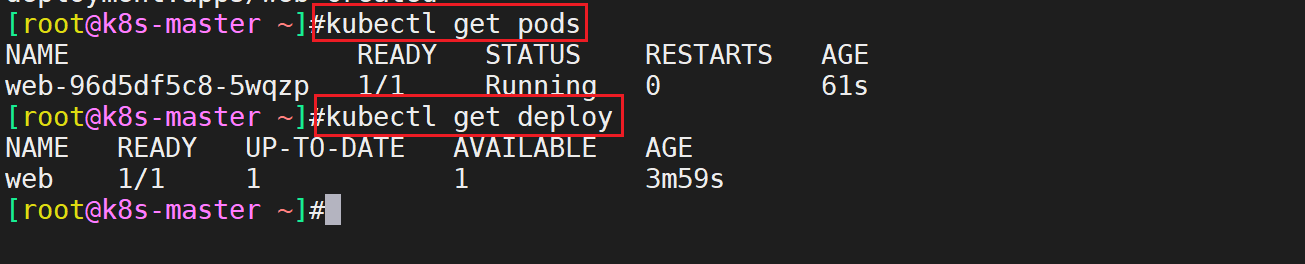

此时用kubectl get pods命令查看pod是否是运行的:

[root@k8s-master ~]#kubectl get pods

[root@k8s-master ~]#kubectl get deploy

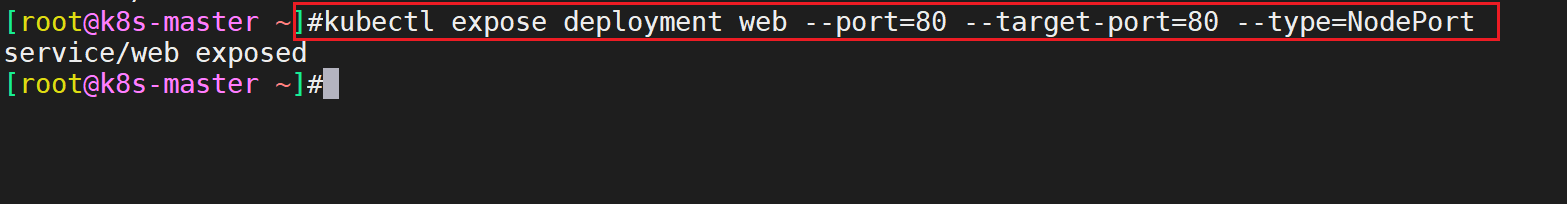

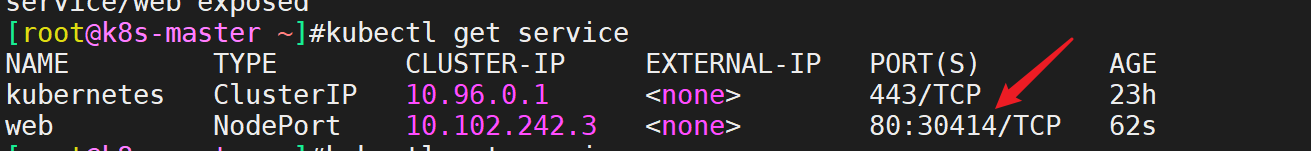

2、使用Service将Pod暴露出去:

[root@k8s-master ~]#kubectl expose deployment web --port=80 --target-port=80 --type=NodePort

#备注

第一个--port是k8s集群内部访问端口,通过集群内部访问的ip, cluster ip;

第二个--target--port是镜像里服务跑的端口号;

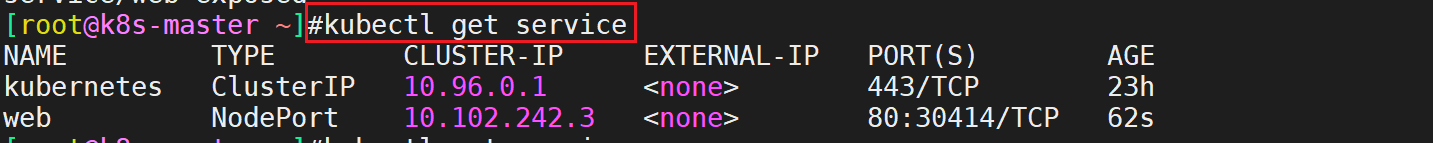

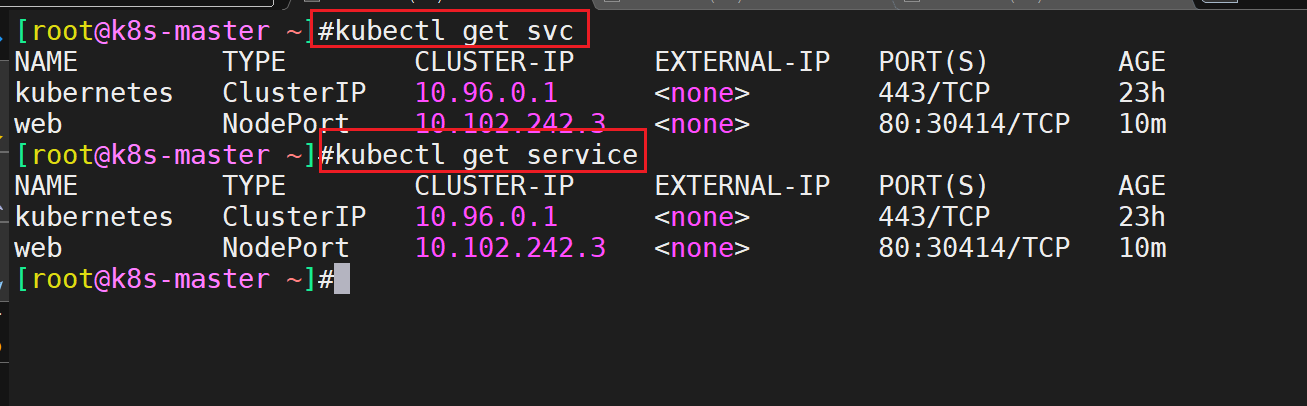

用kubectl get service命令查看刚才创建的service:

[root@k8s-master ~]#kubectl get service

[root@k8s-master ~]#kubectl get svc

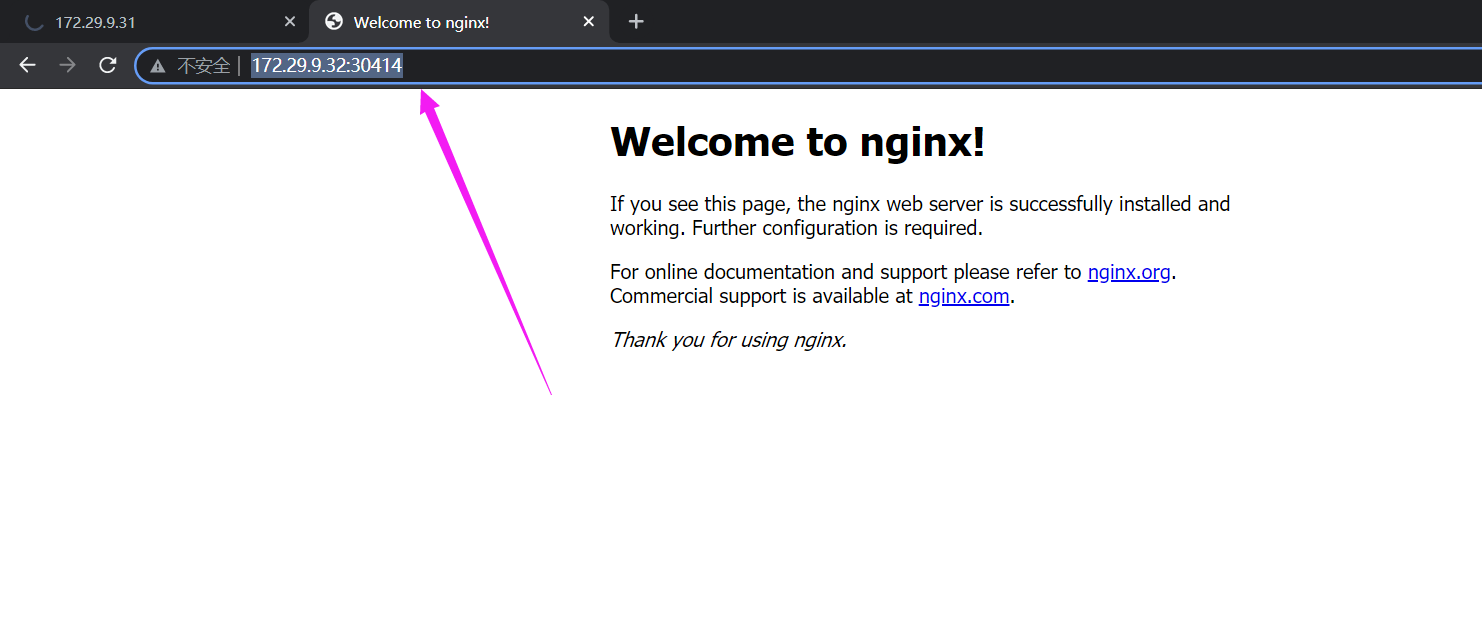

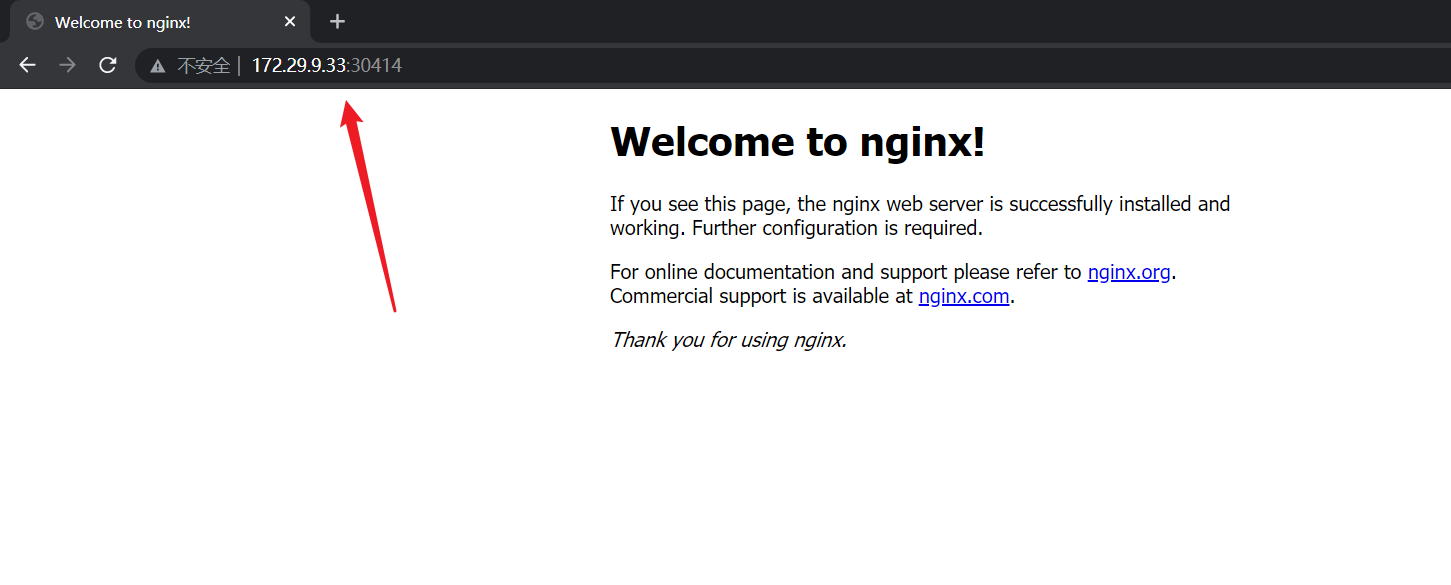

3、访问应用:(实验现象符合预期,完美!) http://NodeIP:Port # 端口随机生成,通过get svc获取

#注意:此时你通过任意的nodeip:端口都可访问nginx应用;(masterip:端口是不行的)

- 此时,再做一个实验快照。

总结

关于快速部署一个Kubernetes集群的步骤可以概括如下:

0.集群环境配置

1.安装Docker

2.创建一个Master节点:kubeadm init

3.将一个Node节点加入到当前集群中:kubeadm join <Master节点的IP和端口>

4.部署容器网络(CNI): kubectl apply -f calico.yaml

5.部署Web UI(Dashboard)

以上就是如何快速搭建一个kubernetets集群的方法了,其实过程挺简单的,初次搭建,可能会遇到一些问题,并且对一些概念不清楚,但是先把实验结果做出来,后续再进一步学习k8s理论等。

关于我

我的博客主旨:

- 排版美观,语言精炼;

- 文档即手册,步骤明细,拒绝埋坑,提供源码;

- 本人实战文档都是亲测成功的,各位小伙伴在实际操作过程中如有什么疑问,可随时联系本人帮您解决问题,让我们一起进步!

🍀 微信二维码 x2675263825 (舍得), qq:2675263825。

🍀 微信公众号 《云原生架构师实战》

🍀 个人博客站点

🍀 csdn

https://blog.csdn.net/weixin_39246554?spm=1010.2135.3001.5421

🍀 知乎

https://www.zhihu.com/people/foryouone

最后

好了,关于本次就到这里了,感谢大家阅读,最后祝大家生活快乐,每天都过的有意义哦,我们下期见!